Рейтинг статьи: 5,00

Продолжаем говорить о том, как создавать и продвигать сайты при небольшом бюджете. В первой части статьи мы разложили по полочкам алгоритм подготовки.

Правильная подготовка требует немалых сил. Она долгая и не очень увлекательная, но без нее сложно добиться успеха в дальнейшем. Думаем, мы убедительно доказали это в предыдущей статье. Во второй части материала будем говорить непосредственно о технической стороне продвижения небольших проектов: информационных сайтов и нишевых интернет-магазинов, которые не имеют серьезных бюджетов на SEO. Поехали.

Вы выбрали тематику, в общих чертах оценили ее перспективность и изучили конкурентов. Решение о запуске сайта принято, и первый технический вопрос, который предстоит решить — это регистрация доменного имени. Придумать звучное название для сайта и зарегистрировать его — дело несложное, но в первый раз обязательно появится много формальных и технических вопросов. Основные из них мы разобрали в статье:

Отдельно отметим, что домены не покупают в бессрочное пользование. Их регистрируют на определенный срок и постоянно продлевают. Непродленные доменные имена выставляются регистратором на повторную продажу. Это значит, что придуманное вами название чисто случайно может оказаться б/у. То есть, сайт с таким именем уже когда-то существовал в выбранной доменной зоне. И несмотря на то что самого ресурса уже нет, информация о нем осталась в памяти поисковиков. Таким образом, вместе с доменом ваш новый сайт получит в наследство поисковый рейтинг предшественника.

Не нужно обладать феноменальной дедукцией, чтобы понять: хорошие трастовые сайты не бросают просто так. Скорее всего, домен не продлили, потому что ресурс залетел под фильтр или не продвигался по другой серьезной причине. Получить в наследство такие проблемы для своего проекта — очень сомнительная перспектива. Именно поэтому после того как вы придумали доменное имя и убедились в том, что оно свободно, следующий обязательный шаг — анализ его истории. Как проверять домены перед покупкой — читайте здесь.

Вопрос создания сайта глупо рассматривать на бегу: в рамках одной статьи и уж тем более небольшого раздела. Этого делать никто и не собирается — здесь вам в помощь тематические ресурсы, книги, видеокурсы. Мы лишь поделимся несколькими важными мыслями с оглядкой на SEO.

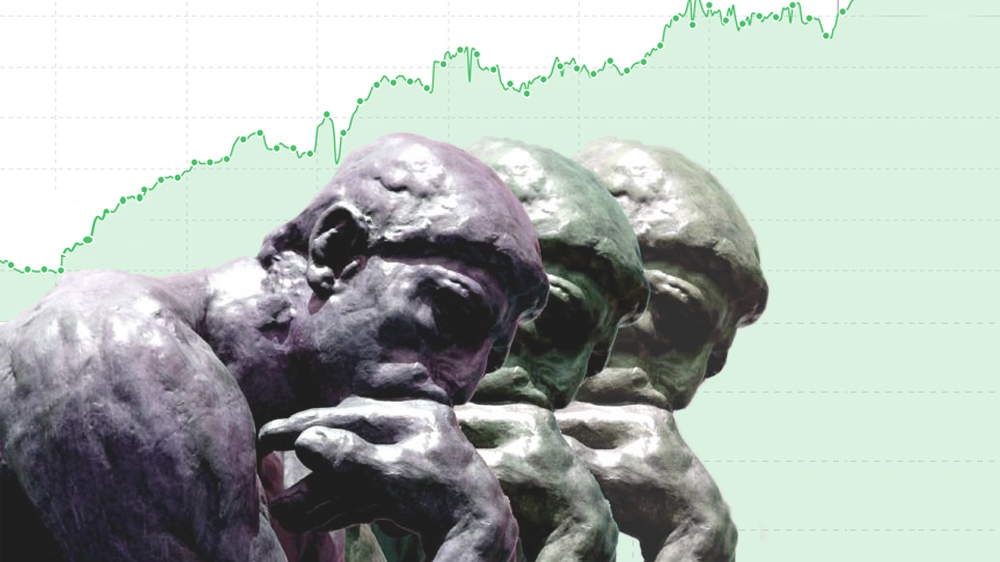

Вариантов запуска сайта по большому счету всего три: создание самописного ресурса с нуля, использование CMS или конструктора. Вариант с самописным сайтом для небольшого проекта с ограниченным бюджетом отпадает сразу (думаем, понятно почему). Остается CMS и онлайн-конструктор.

CMS — это система управления контентом. С ней ничего не нужно писать вручную: весь функционал — от шаблонов дизайна до всевозможных плагинов — уже написали и протестировали сторонние разработчики. Достаточно просто развернуть установочные файлы движка на хостинге, настроить отдельные элементы CMS, наполнить сайт контентом — и проект запущен. Большинство популярных CMS — бесплатные. Функциональные модули (плагины) тоже. Звучит просто и привлекательно, но все же не совсем. Работа с CMS требует знаний и навыков. Управление движком, конечно, нельзя сравнить с написанием кода, но если вы простой сеошник без представлений о разработке — скорее всего, придется искать исполнителя.

Альтернатива движкам — конструкторы сайтов. Условно, это специальные онлайн-сервисы, на которых можно собрать свой сайт. Вам не нужно копаться в программных внутренностях — допиливать код, настраивать структуру папок и т. д. — весь функционал настройки и управления реализован через визуальные интерфейсы. Все понятно на интуитивном уровне.

Конструктор — это удобная штука, когда вы делаете сайт для себя, без планов на монетизацию. Например, если это личный блог, книга своих рецептов или какой-то другой проект для души, на котором вы точно не решите зарабатывать. В остальных случаях мы не рекомендуем связываться с конструкторами. Кратко почему:

Сайты на конструкторах не любят поисковики. Их сложнее продвигать. При прочих равных, конкурент с обычным сайтом гарантированно будет занимать более высокие позиции в выдаче. Да, к некоторым конструкторам, той же Tilda, поисковики более лояльны, но таких примеров немного.

Меньше опций. Некоторые конструкторы обладают неплохим стартовым функционалом, в то же время его нельзя сравнивать с тем количеством бесплатных плагинов, которые написаны для популярных CMS. С конструкторами может быть удобно вначале, но когда вы решите масштабировать и апгрейдить свой сайт — начнутся проблемы. К слову, возможности функционала на бесплатных тарифах часто ограничены.

На конструкторе вы не контролируете свой проект в техническом плане. А это, пожалуй, наибольшая уязвимость с точки зрения внутреннего SEO. Скорость загрузки, оптимизация индексации, настройки административных файлов, чистка дублей и другие критические факторы, напрямую влияющие на ранжирование, оказываются под чужим управлением.

Ограниченная монетизация. С сайтом на конструкторе у вас меньше свободы, в том числе, в плане монетизации: прежде всего это касается баннерной рекламы и контекста. Вы сможете поставить блоки, но с тестированием, размещением и оптимизацией, скорее всего, будут проблемы.

Непривлекательное название. Некоторые сервисы (не все) разворачивают клиентские сайты на поддомене. Простыми словами, это значит, что название вашего сайта будет состоять из двух частей: первая часть — название сервиса и через точку — имя вашего сайта. Такой URL не понравиться ни поисковикам, ни большинству пользователей, и уж точно не добавит авторитетности бренду.

Пару слов про хостинг. С конструкторами этот момент также ускользает из сферы вашего влияния. Вам может повезти — хостинг будет быстрым и без сомнительных соседей, а, может, и наоборот. В любом случае — решать не вам, и вы и здесь на 100% зависимы от владельца сервиса.

Ну и, пожалуй, главный подводный камень: когда вы со временем поймете, что сайт на конструкторе — это несерьезно и захотите перенести свой проект на автономную CMS, так просто решить проблему не получится. В лучшем случае это потребует долгой работы квалифицированного программиста, в худшем — окажется невозможным вовсе.

В условиях ограниченного бюджета информационные проекты целесообразно запускать на бесплатных CMS. Здесь не нужно изобретать велосипед — выбирайте самые популярные движки. В 80% случаев WordPress будет вне конкуренции.

Для магазинов лучший вариант — платные eCommerce-движки. Если бюджет ограничен, свободные CMS — тоже вполне подходят, но в них куда больше подводных камней. Вы должны четко понимать, насколько функционал движка соответствует специфике вашего бизнеса и будет ли его хватать, когда магазин начнет расширяться.

Разнообразие движков может вскружить голову. Поэтому перед тем как разворачивать сайт на какой-либо из CMS, нелишним будет провести несколько вечеров за чтением тематических веток форумов.

Хостинг — это ваше все. Как минимум потому, что от него зависит:

Хороший сервер критично важен, но значит ли это, что молодому проекту нужно сразу тратить непомерно большие бюджеты на ресурсоемкие виды хостинга, в частности, виртуальный сервер (VPS/VDS)? Нет, для нормального и безопасного продвижения на старте будет достаточно и обычного виртуального shared-хостинга. Но (!), если провайдер выбран с умом и предварительно тщательно проверен.

Главное о влиянии хостинга на SEO, как выбрать провайдера, что проверять и когда переезжать — читайте в отдельной статье.

Наличие подписанного SSL-сертификата (защищенного протокола HTTPS) обеспечивает большую безопасность, повышает доверие к сайту и является сигналом ранжирования, важность которого в будущем будет только расти. SSL-сертификат — мастхэв для любого современного ресурса. Вас могут уверять в обратном, доказывая, что HTTPS нужен лишь тем площадкам, на которых проводятся транзакции. Мы считаем, что это не так. Как минимум потому, что метка небезопасный негативно сказывается на пользовательском доверии (читайте: поведенческих). Как максимум потому, что это один из факторов ранжирования.

Сертификат лучше подписывать сразу. В противном случае переезд с HTTP на HTTPS будет связан с техническими сложностями и потенциальными проблемами с внутренней оптимизацией, например, в sitemap останутся URL c HTTP протоколом. Это только один пример. На деле подводных SEO-камней при переезде может быть значительно больше.

Есть несколько разновидностей SSL-сертификатов. Их выбирают в зависимости от специфики сайта. Для рядовых информационников будет вполне достаточно бесплатного сертификата (обычно они доступны прямо в панели хостинга). Для магазинов и других ресурсов, на которых проводят платежи и переводы, имеет смысл подписать платный SSL бизнес-уровня.

Вы запустили сайт. Теперь можно делиться ссылками, настраивать рекламу — и люди будут попадать на его страницы. Но такие переходы — это несерьезно. На сайт должны приходить из поиска. Поэтому первым делом ресурс нужно добавить в индекс, другими словами, зарегистрировать его в поисковиках, проинформировав таким образом роботов Google и Яндекс.

Чтобы новый ресурс начал индексироваться в обоих поисковиках, его добавляют в сервисы Яндекс.Вебмастер и Google Search Console. Для этого в соответствующие разделы обоих вебмастерок загружают карту сайта в xml-формате. Лучше если перед отправкой в индекс на сайте уже есть небольшое количество наполненных и оптимизированных страниц (см. следующий раздел). Вместе с добавлением xml-карты эти страницы отправляют на переобход. Как вариант, сайт можно добавить пустым, и неспешно наполнять его контентом, но не стоит растягивать этот процесс на месяцы.

Google индексирует молодой сайт обычно в течение одной недели. Яндекс — одной-двух. Но это при условии, что все сделано корректно и нет технических проблем для поисковых краулеров.

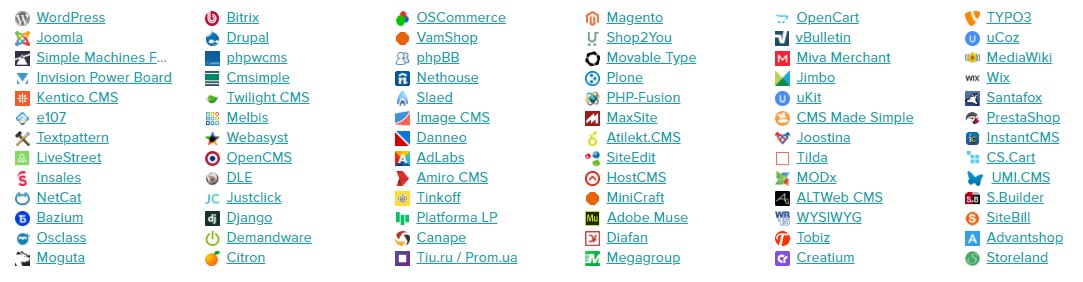

Проверить индексацию всего ресурса или конкретных страниц в Google и Яндекс можно несколькими способами.

1. Через поисковый оператор site:

Вводим оператор site: + название домена (либо конкретной страницы)

Найден 1 результат — значит интересующая страница в индексе.

2. В соответствующих разделах Google Search Console (Индекс Google → Статус индексирования) и Яндекс.Вебмастер (Индексирование → Страницы в поиске ).

3. При помощи браузерных плагинов и специальных программ для проверки индексации. Это больше для тех, кто работает с сайтами на потоке. Новичкам эти способы ни к чему.

Важно понимать, попадание страниц в индекс не гарантирует высоких позиций в поиске. Более того, проиндексированные страницы вовсе могут не отображаться в выдаче по ключевым запросам. Даже если вы запустили сайт, на котором сразу разместили 10–20 грамотно оптимизированных страниц с самым качественным и полезным контентом, ждать быстрого органического трафика не имеет смысла. Это прописная истина для всех, кто не понаслышке знаком с разработкой и продвижением.

Первое время сайт будет находиться в т. н. песочнице. Более подробно о том, что это такое и стратегиях продвижения в первые месяцы после запуска сайта — читайте здесь.

Уже на этапе сбора семантики и анализа конкурентов у вас должна вырисовываться картина структуры вашего сайта. Здесь можно почитать, как разработать структуру, которая будет удобной для пользователей и дружественной для поисковых систем.

Предположим, что структура набросана. Теперь основная задача — оптимизировать ключевые страницы: главную, документы второго и третьего уровней вложенности. Для этого под каждую из страниц выбирается своя группа запросов из семантического ядра. Если вы вдумчиво подошли к проработке семантики и анализу конкурентов, у вас уже будет своя стратегия и виденье, как действовать дальше: какие кластеры запросов использовать на главной, какие на страницах разделов/категорий и подкатегорий.

Под главную обычно отводят ВЧ-запросы с высокой конкуренцией. Страницы второго уровня вложенности оптимизируют под среднечастотные запросы. Остальные документы — под низкочастотную семантику. Но это не жесткие правила, вы можете экспериментировать, ориентируясь на свою персональную стратегию или ситуацию в топе.

Про оптимизацию главных страниц интернет-магазинов можно почитать здесь, а про работу с документами второго уровня вложенности — здесь. Для информационных сайтов алгоритм в целом аналогичен.

Как работать с ключами при оптимизации страниц?

У вас есть список поисковых фраз и понимание того, для каких разделов сайта они предназначены. Дальше необходимо грамотно вписать ключи на каждой странице.

1. Оптимизируем Title — делаем краткий и емкий заголовок с использованием высокочастотного ключа.

2. Вставляем ключевые фразы в заголовки H1-H6. В Н1 также используем высокочастотник, но лучше не такой, как в Title.

3. Остальную семантику и LSI-слова распределяем по тексту (на всякий случай напомним — контент должен быть уникальным). Универсальной схемы, сколько ключей вписывать в текст — нет, но кое-какие дельные советы можно почитать здесь.

4. Не ленитесь заполнять meta description. Его ценность в современном SEO хоть и ставится под сомнение, но он делает сниппет более привлекательным и информативным. Размер описания — от 100 до 250 символов. Вхождение ключей не будет лишним.

5. Оптимизируем фотографии. Обязательно прописываем атрибут alt (с вхождением ключевого слова). А вот заполнение Title носит скорее рекомендательный характер. И лучше сразу компрессировать изображения — это будет нелишним для оптимизации скорости загрузки.

В дальнейшем по этой пятиступенчатой схеме оптимизируют каждый документ, который создают на сайте: будь то посадочная страница нового раздела, статья в блоге или простая карточка товара.

За идеальной SEO-оптимизацией можно гнаться вечно и далеко не всегда это на пользу. Тонкое SEO — это хорошо, когда сайт работает на полном ходу: имеет 100–200 страниц в индексе, дает стабильный трафик из поиска, а с момента регистрации прошло год-полтора. Новичкам, поднимающим свои первые проекты с небольшим бюджетом, мы бы рекомендовали сосредоточиться только на базовом пуле технических работ.

Настройка файла robots.txt

В robots.txt прописаны директивы для роботов Google и Яндекса. Текстовый файл сообщает поисковикам, какие документы на вашем сайте можно обрабатывать, а какие — нельзя. В рамках первичной SEO-оптимизации необходимо убедиться, что директивы прописаны корректно: все важные страницы доступны для индексирования, все нежелательные документы — закрыты.

В помощь начинающему вебмастеру:

Cправка Google по robots.txt

Справка Яндекса по robots.txt

Корректный sitemap.xml

О добавлении Sitemap.xml в вебмастерки Google и Яндекса мы уже упомянули выше. Это нужно, чтобы поисковики узнали о вашем сайте. При создании карты xml важно избегать типичных ошибок:

Оптимизация контента

Как оптимизировать <title>, заголовки H1-H6, сниппет и текст на странице — уже рассказали выше.

Оптимизация URL-адресов страниц

Настройка адекватных URL-адресов — важная составляющая внутренней оптимизации. Это нужно сделать на самом старте, до того как начнется активное продвижение сайта. В противном случае, это доставит много головной боли или же вовсе окажется невозможным без потери позиций страниц в поисковой выдаче.

Вот несколько советов, которые со старта помогут правильно настроить URL-адреса.

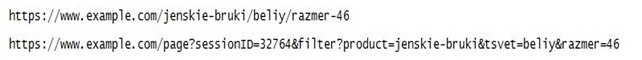

1. Используйте ЧПУ (человеко-понятные урлы), а не численно-буквенные идентификаторы.

2. Избегайте длинных URL — делайте адреса лаконичными. Название должно отражать суть содержимого страницы: урл делают похожим на заголовок. Оптимальная длина — не более 110 символов.

3. В адресе страницы отражайте структуру сайта.

![]()

Это удобно для поисковых краулеров и живых пользователей, которые уже через URL могут сориентироваться в структуре сайта. А также это положительным образом отражается на сниппетах в поисковой выдаче.

4. Не используйте в URL заглавных букв и нижних подчеркиваний. Прописывайте слова в адресе строчными латинскими символами через короткие тире.

Проверка скорости загрузки

Как оценить скорость загрузки сайта и при необходимости ускорить его работу — читайте здесь.

Создание перелинковки

Страницы сайта должны быть связаны между собой ссылками. Этого можно добиться как за счет проставления гиперссылок в тексте, так и посредством более интерактивных форм перелинковки: кросс-контентных блоков, выдачи с похожими или рекомендованными товарами и пр.

Создание перелинковки — не рандомный процесс. Он реализуется в соответствии с семантическим ядром. Если не вдаваться в тонкости, ваша задача — прокачивать внутренними ссылками самые важные разделы сайта. Т. е. на страницы, которые должны давать максимальную отдачу следует ставить больше внутренних ссылок с авторитетных страниц. Более подробно о создании грамотной перелинковки — читайте в отдельной статье.

Сайтам организаций и региональным онлайн-магазинам обязательно нужно делать ставку на локальный поиск. Под таким SEO понимают не только оптимизацию сайта под геозависимые запросы, но и ряд других мероприятий, которые помогают выиграть борьбу за региональную выдачу.

Базовый минимум:

Больше о том, что такое локальное SEO и как продвигать бизнес в региональной выдаче — читайте здесь.

Все о чем мы говорили выше — относится к внутренней оптимизации. Наравне с ней, со старта не меньшее внимание следует уделять внешним факторам ранжирования. Здесь речь идет главным образом о работе с обратными ссылками, т. е. теми линками, которые появляются на ваш сайт на других ресурсах.

Внешняя оптимизация, как и внутренняя — неотъемлемая составляющая продвижения, но ее отличает два принципиальных момента. Во-первых, если техническое SEO можно выполнить единожды и долгое время не возвращаться к нему, то со ссылками так не получится — чтобы удерживать и повышать позиции в поиске с ними нужно работать постоянно. Во-вторых, если принципы технической оптимизации за последние 10 лет изменились несущественно, то в сфере линкбилдига все поменялось кардинально. Здесь все стало жестче и ответственнее, и если вы решите наращивать бэклинки старыми методами — грубо и агрессивно спамить ими на сайтах — вам обеспечен быстрый отклик в виде антиссылочного фильтра, в Google и в Яндексе.

О том, как безопасно и эффективно наращивать внешний ссылочный профиль мы неоднократно рассказывали в своих статьях.

Курс молодого бойца по линкбилдингу:

Как работать с обратными ссылками. Стратегии линкбилдинга 2020

Линкбилдинг без рисков. Как обезопаситься от ссылочного взрыва?

Как проверять ссылочных доноров? Критерии профессионального отбора

Penguin и «Минусинск»: сравнение антиссылочных алгоритмов

Крауд-ссылки и SEO. Почему все не так просто, как кажется?

Попробуем вынести оттуда самое главное:

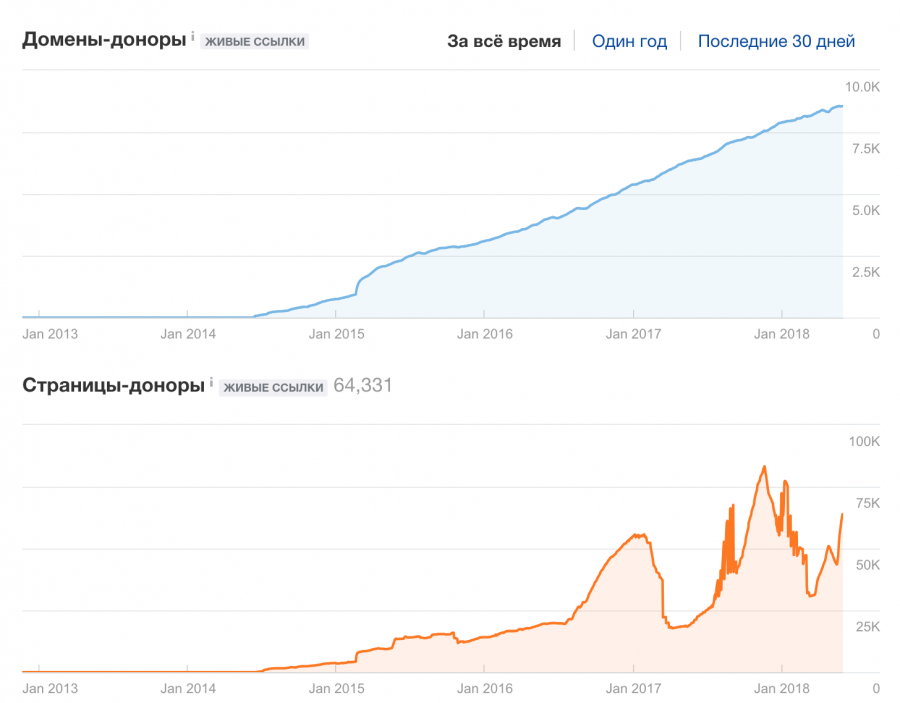

1. Важно соблюдать естественную динамику ссылочного профиля: бэклинки следует наращивать постепенно, без резких всплесков.

Безупречная динамика ссылок и не очень.

2. В анкорах (кликабельном тексте) внешних ссылок не должно быть злоупотребления спамными ключами. Постоянно отслеживайте анкор-лист. Для сайта, который существует минимум год-полтора, оптимальное соотношение анкорных и безанкорных бэклинков — 20 на 80. Для проектов, пребывающих в песочнице, долю анкорных ссылок желательно сделать еще меньшей. И вообще на старте с бэклинками работают очень аккуратно.

3. Чтобы ссылки давали результат, их нужно ставить на разных сайтах.

4. Сами доноры должны не просто иметь хороший траст, но и быть тематически близкими сайту-реципиенту. Размещение ссылок в линкопомойках принесет больше вреда, чем пользы.

5. Контролируйте купленные ссылки. Для отслеживания размещенных бэклинков используйте специальные программы и не ленитесь осваивать весь функционал ссылочных бирж. Стремитесь к тому, чтобы страницы, на которых ставят ссылки, были тематически близкими целевым страницам.

6. Отслеживайте все новые ссылки в инструментах для вебмастеров. Резкий прирост подозрительных бэклинков — возможный сигнал, что вас атакуют конкуренты. Обычно для этого они используют ссылки с сомнительных сайтов или просто спамят анкором. Такие линки нужно закрывать и отписываться в поддержку Google и Яндекса.

7. Работайте над расширением доли крауд-ссылок в своем профиле. Параллельно с этим увеличивайте количество брендовых запросов (простыми словами: делайте так, чтобы названия вашего сайта пользователи чаще вбивали в поисковик).

Разговором о внешних ссылках мы будем заканчивать наш материал. Он не претендует на статус исчерпывающего чек-листа по SEO-оптимизации. Это в большей степени дорожная карта, которая поможет не растеряться в начале, грамотно запустить свой проект и избежать фатальных ошибок.