Рейтинг статьи: 5,00

Резкое снижение трафика, просадка позиций, вылет из индекса группы страниц или сайта целиком, – все это крайне пессимистичный, но вполне реальный сценарий, которого боится каждый вебмастер. Причин такой негативной динамики может быть немного. Чаще всего это говорит о том, что сайт оказался под санкциями поисковой системы. Речь идет об ограничительных мерах, которые поисковики накладывают за грубое нарушение правил SEO-продвижения.

Санкции могут быть применены к сайтам разного возраста, тематики и трастовости, хотя практика и показывает, что у молодых доменов намного больше шансов получить проблемы из-за манипуляций с оптимизацией. Вряд ли это объясняется фактором возраста как таковым, скорее всего, у трастовых площадок просто больше положительных SEO-сигналов, которые оттеняют негативный эффект серой оптимизации.

Систему санкций активно применяют и в Google, и в Яндексе. Сами штрафы и механика их наложения очень похожи в обеих ПС, но в этом материале мы будем говорить именно о Google. Практика показывает, что пессимизация в этой поисковой системе более жесткая, прилетает чаще и полностью оправиться от нее сложнее. Отсутствие вменяемого саппорта – еще одно принципиальное отличие, которое добавляет сложностей при проблемах на сайте. К эффективности яндексовских «платонов» может возникать много вопросов, но факт их наличия – существенный плюс.

Резкий обвал трафика может происходить не только из-за санкций поисковых систем. Разбор ситуаций, когда посещаемость падает по независящим от вас причинам – читайте здесь.

Санкции поисковой системы Google бывают двух видов: алгоритмические и ручные.

Алгоритмические штрафы, или фильтры, накладывают автоматически, когда поисковые роботы замечают использование запрещенных методов оптимизации. В зависимости от нарушения, фильтр распространяется на весь домен или ограниченную выборку страниц. Отдельно отметим, что Google не использует термина «фильтр», но это понятие прочно укрепилось в лексиконе оптимизаторов, и под ним понимают именно алгоритмическую пессимизацию.

Сайт могут подвергнуть автоматической пессимизации не только за нарушение правил продвижения, но и за низкое качество как таковое. Критерии качества, которые также называют факторами ранжирования, постоянно меняются. С выходом нового апдейта сайт может резко потерять позиции и трафик, без каких-либо уведомлений. Именно поэтому каждый новое обновление поискового алгоритма наводит большой переполох в среде оптимизаторов. Отдельно отметим, что Google выкатывает такие апдейты несопоставимо чаще, чем Яндекс.

Ручные санкции, как следует из названия, накладывают вручную или полуавтоматически. Когда по сайту есть подозрительные сигналы, специалисты Google (асессоры) проверяют его содержимое и при необходимости подвергают пессимизации. Практика показывает, что для ручных санкций в большей степени характерна просадка позиций: обычно страдают конкретные страницы или группы страниц. Деиндексация отдельных URL или всего сайта в целом происходит редко.

В этой статье мы будем говорить главным образом об алгоритмических штрафах и факторах ранжирования. Основные проблемы, за которые Google наказывает в ручном режиме, подробно разобраны во второй части нашего материала. Спойлер: о них нужно знать даже тем, кто является принципиальным сторонником белого SEO и не использует запрещенных методов оптимизации, т. к. нередко такие санкции прилетают из-за действий третьих лиц.

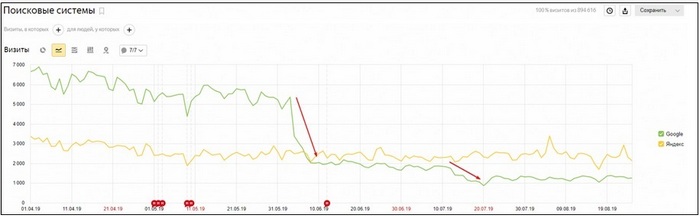

При алгоритмической пессимизации вебмастер не получает никаких уведомлений. Понять, что сайт попал под фильтр, можно только по косвенным признакам, связанным с колебаниями трафика. Первым делом проверяют, из какой именно поисковой системы пропали переходы.

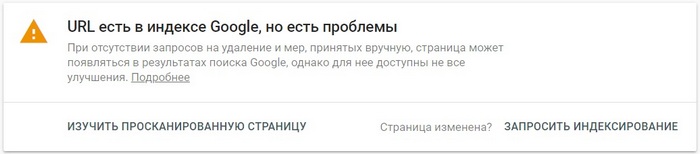

Далее выясняют, упал трафик полностью или нет. Если под фильтр залетела только часть сайта, нужно понять, какая именно группа страниц пострадала. После этого выясняют характер самой пессимизации: идет ли речь о просадке позиций или об удалении страниц из индекса. Чтобы посмотреть, остались ли пессимизированные страницы в индексе, воспользуйтесь инструментом проверки URL в Search Console:

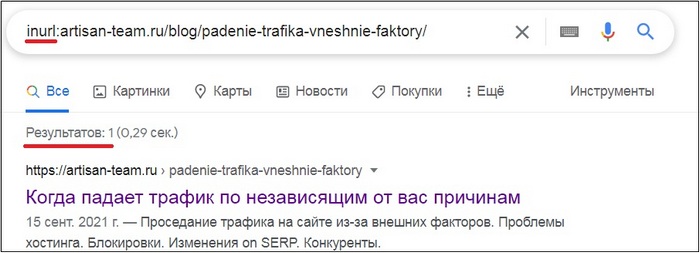

Также можно просто проверить, отображает ли Google нужную страницу в поиске или нет:

Учитывая тот факт, что на саппорт в Google рассчитывать не приходится, вебмастеру остается самому догадаться о причине наложения фильтра. На практике это сделать не всегда просто, особенно когда на сайте применялись разные методы недобросовестной оптимизации, и не до конца ясно, за что именно прилетело от поисковика. Все усугубляет и неопределенность: непонятно, то ли вы исправляете что нужно, а также даст это положительный результат или нет. С учетом всего перечисленного алгоритмические штрафы деморализуют несопоставимо сильнее. Возможно, именно поэтому сайты под фильтрами чаще забрасывают. К слову, об этом нужно помнить, когда вы решите подхватить «перспективный дроп» или купить сайт по очень хорошей скидке.

Проверить сайт на предмет алгоритмической пессимизации в Google помогают специальные сервисы. Нельзя сказать, что это на 100% рабочий способ, но часто они способны прояснить ситуацию, особенно когда речь идет о просадках, связанных с обновлением поискового алгоритма.

Panguin Tool – англоязычный сервис для проверки основных алгоритмических фильтров Google, таких как Penguin, Panda и пр. Для работы инструмента нужен доступ к Google Analytics.

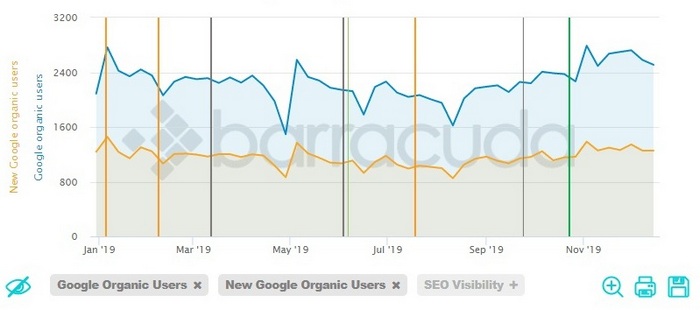

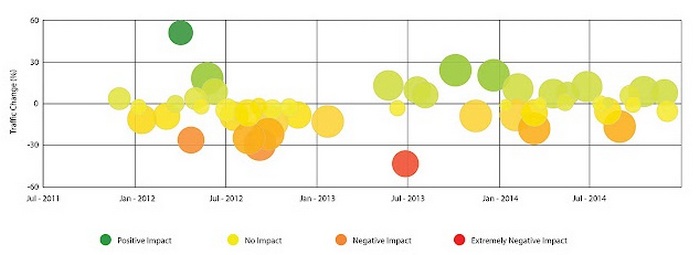

Вертикальными линиями показаны все обновления поисковых алгоритмов Google — можно сразу понять, как они повлияли на органический трафик

Website Penalty Indicator – аналогичный инструмент, показывающий динамику трафика с привязкой ко всем обновлениям поискового алгоритма.

Google Penalty Checker – основная идея этого инструмента во многом идентична аналогам, но здесь использован другой принцип визуализации. Влияние обновлений алгоритмов Google на трафиковость сайта отображается градацией цветов: зеленый – положительное влияние, желтый – нейтральное, оранжевый и красный – негативное.

Как таковые фильтры уже давно не существуют по отдельности, а интегрированы в глобальные алгоритмы поискового ранжирования. Например, два самых известных фильтра «Панда» и «Пингвин» объединены в общий алгоритм ранжирования и применяются вместе. Тем не менее чтобы лучше понять требования Google к качеству сайтов, а также логику реализации автоматических санкций, кратко рассмотрим, как работает и за что отвечает каждый из ключевых алгоритмов в отдельности.

Антиссылочный фильтр, который с 2016 года является частью поискового алгоритма Google. Его основная задача – борьба с искусственным ссылочным продвижением. Санкции применяются как автоматически (без уведомлений), так и вручную (с соответствующим оповещением в Search Console). Алгоритмические штрафы накладывают за следующие нарушения:

Алгоритм определяет все искусственные ссылки и обесценивает их роль в ранжировании сайта. Таким образом, последствия от этих штрафов обычно проявляются на уровне конкретных страниц, которые усиливались спамными ссылками, и они проседают в поисковой выдаче. В своей «ручной» версии антиссылочные санкции могут приводить к более серьезным последствиям.

Под прицелом «Панды», которая в свое время также являлась самостоятельным фильтром, а позже стала частью глобального алгоритма Google, находится контент сайта и качество его организации в целом. Алгоритм анализирует метрики эффективности постранично, но его влияние распространяется на весь ресурс.

«Панда» охватывает большое количество параметров, и если качество внутренней оптимизации не соответствует установленным требованиям, происходит автоматическая пессимизация. Обычно в этом случае наблюдается значительное проседание позиций по обширной группе запросов, но в некоторых случаях возможна деиндексация всего сайта. Если нарушений немного, пессимизация распространяется только на часть ранжируемых запросов.

Перечислим факторы, увеличивающие риск наложения этого фильтра (по степени значимости):

Помимо самого контента и его организации на странице, причиной просадок нередко становится плохая техническая оптимизация: низкая скорость загрузки, кривая верстка, плохая адаптивность на устройствах, не доработанное юзабилити.

Риск наложения «Панды» напрямую коррелируется с поведенческими метриками. Когда происходит обвал трафика, и нет уверенности, отчего именно пострадал сайт, нужно смотреть показатели отказов и время длительности визитов. Если эти метрики были критически низкими – вероятнее всего, сайт залетел именно под «Панду». К слову, это один из самых тяжелых фильтров, и от него сложнее всего оправиться. Но и попадают под него лишь те ресурсы, к которым, действительно, много вопросов в плане качества.

Семантический алгоритм, который анализирует смысловую релевантность текстов на сайте. «Колибри» не фильтр в классическом понимании и никогда таковым не являлся, но именно он во многом отвечает за то, будут ли страницы сайта иметь хорошие позиции (и трафик) по конкретным запросам или нет.

С «Колибри» приоритет в ранжировании получают те страницы, чей контент наиболее полно удовлетворяет интент (намерения) пользователя. И дело здесь не только в ответе на вопрос как таковой. Алгоритм учитывает полноту раскрытия темы и в целом уровень качества предложенного материала. Также он анализирует общее семантическое ядро и таким образом определяет тематику ресурса. Это очень важно, поскольку в современном поиске приоритет получают нишевые сайты, охватывающие более узкие темы.

Чтобы оптимизировать сайт под этот алгоритм, текстовое наполнение должно соответствовать следующим требованиям:

Чтобы предоставить пользователям поиска максимально качественные и релевантные страницы по их запросам, Google использует сложную систему ранжирования. Она строится не только на описанных выше алгоритмах (это далеко не полный список), но и множестве дополнительных сигналов, т. н. факторах ранжирования. Поговорим о наиболее значимых из них.

Разговор о качестве контента будет неполным без упоминания гугловской концепции E—A—T. Это аббревиатура от expertise (экспертность), authoritativeness (авторитетность), trustworthiness (достоверность) – трех метрик оценки качества контента. Формально, писать статьи с соблюдением этих критериев важно для всех сайтов, но в отдельных нишах требования E‑A-T играют в прямом смысле решающую роль. Речь идет о так называемых YMYL-тематиках, напрямую влияющих на здоровье и благосостояние людей.

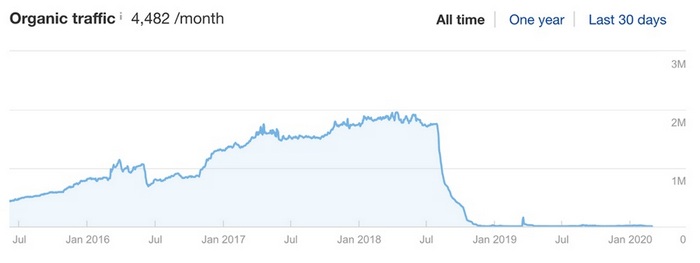

Последствия медицинского апдейта в 2018 году, после которого стали много говорить о E‑A-T

Пессимизацию за несоответствие требованиям E‑A-T в таких тематиках, как медицина, финансы, право иногда называют YMYL-фильтром. Это неофициальная терминология, и здесь нелишним будет еще раз напомнить, что Google и вовсе не использует этого понятия. Также E‑A-T не совсем корректно называть фактором ранжирования, поскольку в отличие от остальных технических параметров, его невозможно измерить напрямую, хотя по своей функциональной сущности он, безусловно, является таковым.

Чтобы иметь хорошие позиции в поиске, статьи на YMYL-сайтах должны писать специалисты с подтвержденным уровнем экспертности. Для оценки и верификации этих параметров в Google используют свою алгоритмическую модель, предполагающую в т. ч. асессорскую проверку. Пренебрегая этими требованиями, сайты в таких тематиках, как медицина, право, финансы вряд ли смогут рассчитывать на высокие позиции в выдаче. Больше о том, как соответствовать требованиям E‑A-T – читайте в отдельной статье.

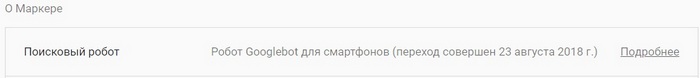

Для получения высоких позиций в поиске в Google решающее значение имеет качество мобильного представления сайта. Еще в 2018 году в компании заявили о внедрении новой модели индексирования Mobile First Index, согласно которой индексирование и, соответственно, получение приоритета в ранжировании должны происходить на основе мобильной версии сайта. Все эти годы происходило поэтапное внедрение нового подхода, и, наконец, в марте 2021 года Google полностью перешел на модель индексирования с приоритетом мобильного контента. Убедиться в этом можно в Search Console, в меню настройки:

Сайт индексируется в мобильной версии

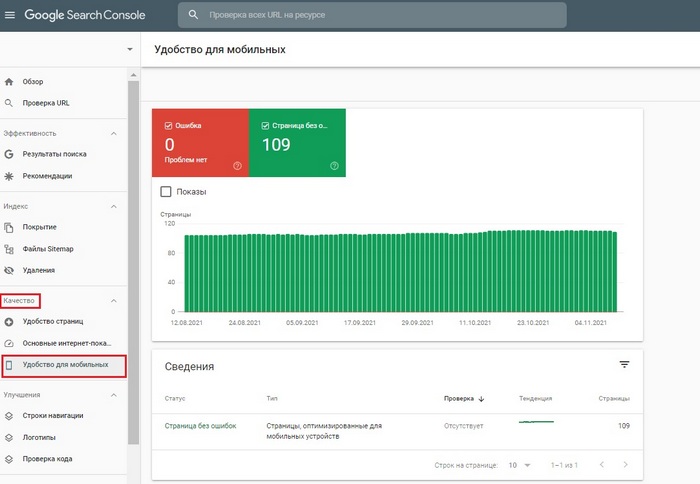

Все seo-сигналы Google теперь получает из мобильного индекса. Если к адаптивной версии сайта есть вопросы и эти сигналы слабые – позиции в выдаче и трафик будут соответствующими. Таким образом, качество мобильного представления является абсолютным приоритетом для продвижения в Google. Инструменты и отчеты, которые позволяют отслеживать, насколько хорошо страницы сайта просматриваются на мобильных устройствах, доступны в Search Console.

Качество → Удобство для мобильных

Google не любит медленные сайты. Скорость загрузки страниц является одним из ключевых факторов в общем алгоритме ранжирования еще с 2018 года, с того момента, как представили обновление Google Speed Update. Логика этого апдейта была проста: очень медленные сайты получали более низкие позиции в выдаче, в то время как на остальные ресурсы (быстрые и со средней скоростью) апдейт не распространялся. Все это затрагивало только мобильный поиск, в соответствии с вышеупомянутым Mobile First Index.

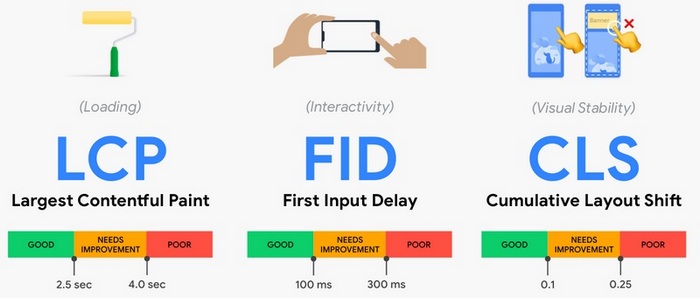

С 2021 года Google использует более продвинутую модель для оценки производительности страниц — Core Web Vitals. Здесь речь идет уже не только о скорости (хотя она важнее всего), но и удобстве работы со страницами как таковыми. Core Web Vitals – это группа метрик, с помощью которых Google оценивает, насколько страница удобна для пользователя в процессе взаимодействия.

Метрики эффективности Core Web Vitals и их рекомендуемые значения

Core Web Vitals включает три базовых метрики:

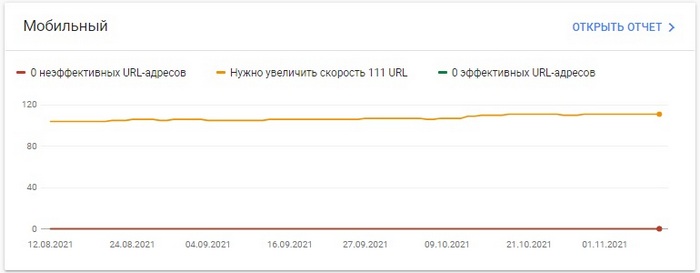

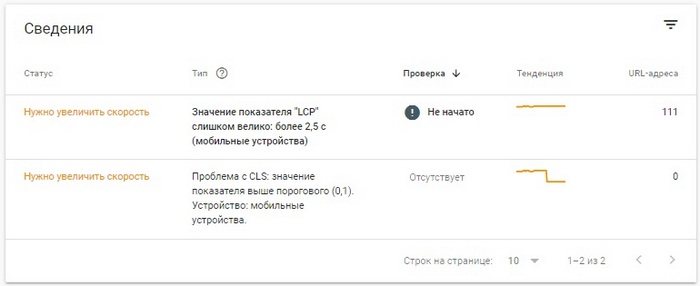

Посмотреть эти показатели можно в отчете Google Search Console.

Качество → Основные интернет показатели → Мобильный (для ранжирования важны сигналы именно с мобайла)

Здесь наглядно показано, насколько разные страницы сайта соответствуют параметрам Core Web Vitals. Внизу представленные расширенные сведения о конкретных проблемах и перечень затронутых страниц.

Проверить метрики Core Web Vitals можно и через другие инструменты Google:

При ранжировании по запросам с явным коммерческим интентом, алгоритмы Google используют дополнительную группу сигналов ранжирования. Речь идет о так называемых коммерческих факторах. Под ними понимают элементы и характеристики сайта, помогающие алгоритмам оценить качество бизнеса, стоящего за ресурсом. Речь идет по большей части о хостовой группе факторов, то есть таких, что описывают сайт целиком и не зависят от конкретного запроса или страницы.

В формуле коммерческого ранжирования Google приоритет отдается таким факторам, как широта ассортимента, доверие пользователей, ясная ценовая политика, качество услуг, удобоваримый дизайн, безопасность. Они распространяются в первую очередь на онлайн-магазины, сайты услуг и другие ресурсы, которые получают трафик по запросам с явным потребительским интентом.

Элементы и характеристики сайта из группы коммерческих факторов

Отдельно отметим, что поиск Яндекса работает по аналогичной модели, и все перечисленные элементы и характеристики сайта здесь играют такую же важную роль для хорошего ранжирования по коммерческим запросам.

Использование защищенного протокола HTTPS еще с 2014 года является официальным фактором ранжирования Google1. Со временем роль этого показателя значительно усилилась, причем не только для коммерческих сайтов, где происходит передача чувствительных данных, например, банковских карт, но и для любых других проектов. Сегодня почти нереально встретить незащищенный HTTP-сайт на первой странице поисковой выдачи, и лишний раз напоминать о важности перехода на HTTPS – даже как-то несерьезно.