Рейтинг статьи: 5,00

Сайрус Шепард из MOZ опубликовал материал, в котором собрал простые и неочевидные рекомендации для быстрой SEO-оптимизации сайтов1. Мы внимательно прочитали это руководство — кое-что добавили от себя, местами адаптировали его советы под здешние поисковые реалии — и теперь пересказываем главное. Получилась своего рода дорожная карта для тех, кто хочет улучшить позиции сайта путем минимального вмешательства.

В предыдущей статье мы рассказывали о тонкостях оптимизации сниппетов. Там мы поделились техническими лайфхаками, которые помогают получать больше переходов, сохраняя текущие позиции в выдаче Google и Яндекса. Здесь речь пойдет об оптимизации содержимого страниц: контенте, ссылках и других технических внутренностях ресурса.

Перезапуск старых статей пойдет на пользу любому контентному проекту. На таких ресурсах происходит в целом одна и та же картина. На них постоянно публикуют материалы, часть из которых занимает позиции. Некоторые — вполне высокие. Оптимизатор радуется этому факту и внимательно следит за цифрами. Со временем интерес к метрикам пропадает, и проседание позиций часто остается просто незамеченным. Это неправильный подход.

Контент имеет тенденцию к устареванию. Это происходит даже если вас не теснят конкуренты, что, к слову, большая редкость. Позиции постепенно теряют в том числе самые качественные статьи, наиболее полно и авторитетно раскрывающие запрос. И для Google, и для Яндекса свежесть контента — важный фактор ранжирования. Поэтому необходимо периодически проводить аудит содержимого: обнаруживать те статьи, которые просели и обновлять их на тех же URL’ах. По-хорошему, такую актуализацию нужно проводить каждый год.

Основная задача здесь — найти статьи, которые раньше собирали много трафика, но из-за просевших позиций ухудшили свои показатели. Сделать это можно двумя способами.

1. Снять позиции по запросам и создать выборку страниц с сильно просевшими показателями. Это быстро и удобно, но понадобится специальный софт. Способ актуален в первую очередь для тех, у кого уже есть подписка на серьезный SEO-анализатор, умеющий отслеживать изменение позиций по запросам.

2. Найти контент для перезапуска можно и при помощи штатной Яндекс.Метрики.

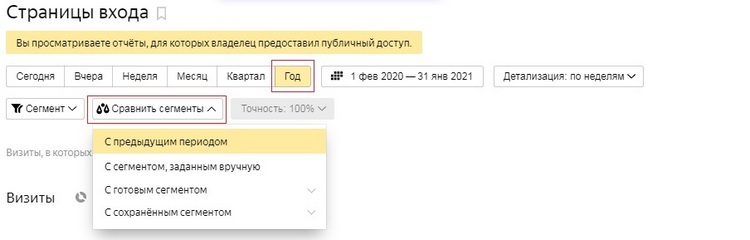

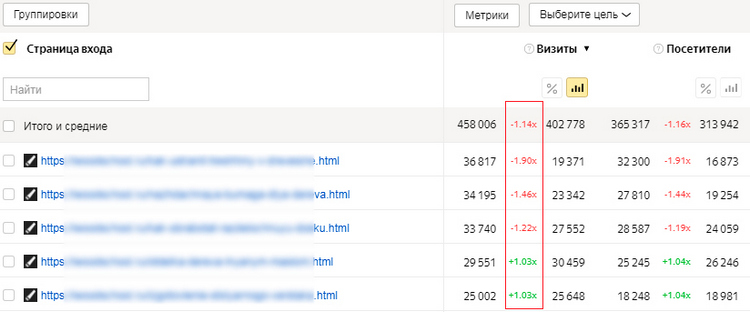

✓ Отчет «Страницы входа» → Сравнить сегменты (задаем относительно продолжительный период).

✓ Смотрим разницу по визитам → Страницы с просевшими показателями выносим в отдельный список.

✓ Более детально изучаем показатели по каждой странице, и решаем, обновлять ее или нет.

1. Обновите старый контент, дописав 1,5-2,5 тыс. знаков.

2. Не меняйте URL-адрес. Это очень важно. В противном случае для поисков страница будет выглядеть не как обновленный, а новый (неуникальный!) контент.

3. Обновите дату публикации. Это тоже очень важно.

4. В вебмастерках обоих поисковиков отправьте страницы на переобход.

Совет!

Обновляйте контент с учетом семантической актуализации — расширяйте ядро и добавляйте новые релевантные ключи.Так у ваших статей появится шанс не просто восстановить позиции, а начать охватывать еще большую аудиторию, генерируя на сайт дополнительный трафик.

PRO совет!

Придержите часть контента для актуализации. Публикуйте новые материалы не полностью, оставляя в резерве 1-2 тыс. знаков, чтобы доопубликовать их через какое-то время. Естественно, это никак не должно влиять на цельность статьи в первой редакции.

О важности перелинковки не говорил только ленивый. Если очень коротко: трастовые разделы сайта должны ссылаться на страницы более низкого уровня. Больше о базовых принципах создания эффективной перелинковки можно почитать здесь. Практика показывает, что потенциал для усиления внутренних ссылок есть на большинстве сайтов, и этим нужно пользоваться.

Создание перелинковки — это непрерывный процесс, который следует поддерживать, пока на сайте появляются новые страницы. Публикуя контент, нужно искать возможность проставить в нем релевантную ссылку на старые материалы. Причем не следует забывать возвращаться в старые статьи и, если это уместно, ставить в них ссылки на новые публикации. Таким образом, вы добавляете релевантности старым материалам и отчасти актуализируете их для поисковиков.

Создание внутренней перелинковки — весьма непростая задача, когда речь идет о больших контентных проектах. В этом случае можно использовать один из двух способов поиска релевантных статей для проставления внутренних ссылок.

1. Сайрус Шепард предлагает делать это через Keyword Explorer в Google Search Console. В вебмастерке Google можно просмотреть страницы, которые ранжируются по нужному ключевому слову. Таким образом мы получаем выборку тематически близких материалов.

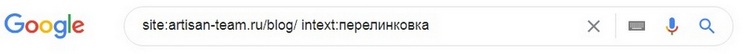

2. Второй способ основывается на использовании двух операторов расширенного поиска Google — site: и intext:

— при помощи оператора site: задаем сайт, которым будут ограничены результаты поиска. При необходимости сразу указываем раздел, где нужно искать (artisan-team.ru/blog)

— второй оператор intext: ограничит выдачу только теми результатами, в которых присутствует указанное ключевое слово.

Например, через команду site:artisan-team.ru/blog/ intext:перелинковка мы получим перечень всех материалов в нашем блоге, в которых упоминается перелинковка. Эти статьи — потенциальные кандидаты для проставления релевантных ссылок.

Сосредотачивая внимание на бэклинках, многие забывают о неоптимизированных внутренних ссылках. Со временем их может накопиться очень много, и это, по мнению Сайруса Шепарда, способно не лучшим образом сказываться на ранжировании. Итак, какие внутренние ссылки стоит удалить.

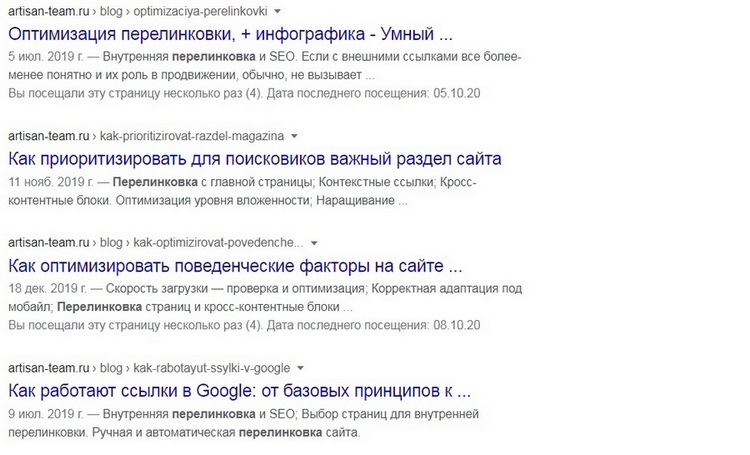

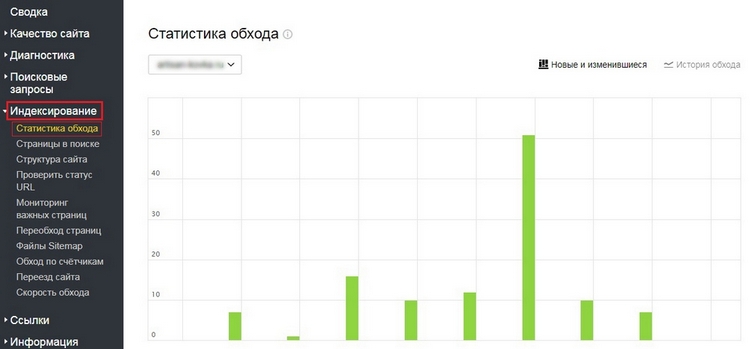

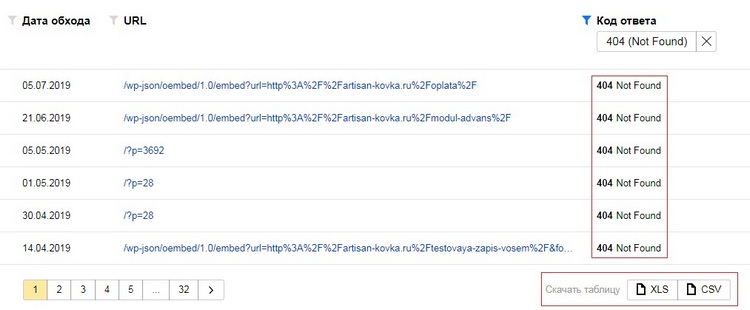

В первую очередь — неработающие. Это особенно актуально для eCommerce-сайтов с их динамичной и постоянно обновляемой структурой. Битые ссылки ухудшают поведенческие на сайте и плохо сказываются на поисковой репутации, а когда их накапливается очень много — нерационально расходуют краулинговый бюджет. Битые линки следует периодически чистить. Но для начала их нужно найти. В этом помогут штатные консоли: Яндекс.Вебмастер и Google Search Console.

Проверка сайта на битые ссылки в Яндекс.Вебмастере

Вторая менее очевидная проблема, на которую указывает Шепард, — неоптимизированная ссылочная архитектура. Например, ссылки на раздел «О компании», доступные с каждой страницы сайта, или линки на контакты организации, стоящие там, где не нужно. Такая ссылочная структура может быть избыточной и не нести реальной пользы. Если удалить ненужные ссылки, остальные линки на странице смогут получать больше веса, что, по мнению Сайруса Шепарда, станет положительным сигналом для Google и сможет улучшить ранжирование.

Совет!

Провести быстрый аудит внутренних ссылок на своих страницах можно с помощью бесплатного расширения SEO Pro Extension, на которое мы делали отдельный обзор.

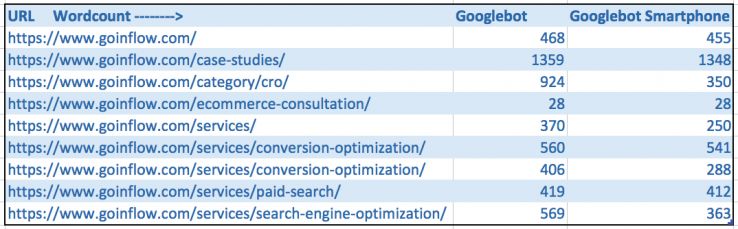

Объем текстового контента некорректно считать прямым фактором ранжирования. Короткие статьи прекрасно залетают в топ и ранжируются по самым разным запросам, по крайней мере в Google. В то же время лонгриды влияют на поисковую репутацию сайта опосредованно — улучшают поведенческие факторы, собирают больше ссылок и расшариваний, чем короткие статьи. Этот факт находит подтверждение в разных исследованиях2, и является весомым аргументом в пользу того, чтобы пересмотреть свою контентную-политику и увеличить в ней долю лонгридов.

Эта рекомендация особенно важна в контексте предыдущего пункта, когда пишут длинные тексты. Что-то кардинальным образом новое здесь посоветовать сложно. Структурируйте контент при помощи логичных, информативных и оптимизированных под семантику тегов H2 и H3. В заголовки H2 помещайте среднечастотные ключи, в подзаголовки H3 — низкочастотники. Это добавит контекстуальной релевантности и увеличит шансы на попадание страниц в блок быстрых ответов.

Вам также может быть интересно: Google featured snippet: как оптимизировать страницу под выделенные описания

Тематический кластер — это группа страниц, организованных вокруг большой темы. Каждая статья здесь подробно раскрывает конкретный аспект общей проблемы. Все материалы связаны между собой продуманной семантикой, хорошо организованной и вовлекающей перелинковкой. Такой принцип написания контента не только увеличивает длительность пользовательских сессий и глубину просмотров, но и что более важно, мотивирует значительную часть аудитории возвращаться на сайт для дальнейшего прочтения материалов. Это в свою очередь наращивает процент «закладочников» и увеличивает долю брендовых запросов. Для поисковиков это важные сигналы, улучшающие репутацию сайта.

Такой контент-кластер лучше делать с нуля. В этом случае нужно собрать ядро общетематических запросов и разбить их на логические группы, под каждую из которых будет писаться статья. Создать кластер можно и на базе уже существующего контента. В качестве главной статьи целесообразно брать самые трафикогенерирующие публикации и дополнять их материалами, которые будут раскрывать более узкие аспекты. В этом случае важно вдумчиво проработать упущенные ключи, так чтобы расширить семантический охват и при этом исключить каннибализацию запросов.

Если на страницах есть контент, который спрятан в разворачивающихся блоках, лучше извлечь его оттуда. Некоторые исследования3 вполне убедительно подтверждают тот факт, что скрытие текста в аккордеонах и других разворачивающихся элементах, ухудшает качество пользовательского опыта. На всякий случай сделаем акцент на том, что речь идет только о взаимодействии пользователей с интерфейсом. Нет никаких оснований полагать, что Google или Яндекс хуже ранжируют скрытый контент. Если это и происходит, то только через поведенческие факторы.

Тем же, кто принципиально не хочет отказываться от такой организации контента, обязательно следует дать пользователям UX-подсказку на своих интерфейсах. Например, на аккордеоне это может быть надпись «Разверните, чтобы узнать больше» или «Листайте влево», если это карусель с фото.

О технической стороне поисковой оптимизации можно говорить много и долго. В своем руководстве Сайрус Шепард перечисляет только самое важное и дает ряд неочевидных советов с учетом актуальных тенденций. Эти рекомендации больше продвинутого уровня. Об основах технического SEO для молодого сайта — читайте в этом материале.

Модель ранжирования mobile first заставила многих пересмотреть отношение к мобильной оптимизации сайта. Те, кто сегодня делают ставку на трафик из Google, хорошо понимают важность подготовки качественной мобильной адаптации. Автор руководства обращает внимание на один неочевидный момент: в процессе масштабирования десктопной версии, сайты теряют внутренние ссылки. Это отчасти естественно, поскольку упрощается навигация, оптимизируется структура и т.д. Но чтобы не терять ссылочный капитал, Шепард рекомендует провести аудит ссылок на разных платформах и убедиться, что разница между мобильной и десктопной версией некритичная.

Многие SEO-аналитики сходятся во мнении, что 2021 и ближайшие последующие годы пройдут под знаком Core Web Vitals. Это следует учитывать, если вы делаете ставку на трафик из буржунета. Google выводит на передний план целую группу метрик ранжирования. Наиболее важные из них — скорость загрузки сайта и качество пользовательского опыта на страницах. Требования к этим в общем-то стандартным метрикам стали более техническими. В то же время Google предлагает некоторые обновленные инструменты, такие как Lighthouse, которые помогут понять, насколько хорошо сайт соответствует новым требованиям и какие его слабые места нуждаются в оптимизации в первую очередь.

Больше читайте здесь: Новые факторы ранжирования Google: как подружить сайт с Core Web Vitals

Максимальный лимит URL–адресов, которые могут быть перечислены каждом файле Sitemap — 50 000. Тем не менее, чтобы исключить проблемы с индексированием, карту сайта рекомендуют ограничивать 10 тысячами URL-адресов. Это особенно актуально для больших и часто обновляемых сайтов, например, магазинов, которым важно, чтоб страницы как можно быстрее залетали в индекс.

Сайрус Шепард отмечает, есть все основания считать, что использование Sitemap с ограниченным набором URL-адресов увеличивает вероятность на более быстрый обход. Похоже на то, что алгоритмы Google каким-то образом расставляют приоритеты с учетом этого фактора. Оптимизация Sitemap также улучшает сбор данных в Google Search Console.

Существует еще одно решение, направленное на оптимизацию индексации крупных и часто обновляемых сайтов. Если у вас есть большой список URL-адресов, вы можете сделать короткий Sitemap с наиболее приоритетными страницами, а как только они проиндексируются — заменить их на новые. Это совет актуален в первую очередь для тех сайтов, на которых ежедневно создается действительно большой корпус URL-адресов (100 и более), и от всех этих страниц ждут быстрого попадания в индекс.

Фундаментально в этом вопросе ничего не поменялось. Внешние ссылки все также важны для ранжирования, а к их качеству поисковики по-прежнему очень требовательны. Развитие сильного ссылочного профиля — это сложно и дорого, поэтому оптимизаторы, как правило, не очень любят линкбилдинг. Вот несколько советов, которые отчасти упростят жизнь в этом вопросе.

Пассивное наращивание ссылок предполагает создание контента, который пользователи будут сами находить в поиске и делиться им. Исходя их этого, во-первых, все статьи нужно вдумчиво оптимизировать под ключи, во-вторых, сам формат публикаций должен располагать к тому, чтобы ими делились. Практика показала, что у аудитории намного лучше заходят пошаговые инструкции, гайды, исследования. Больше о самых расшариваемых форматах и тематиках читайте здесь: Какой контент полезен для SEO

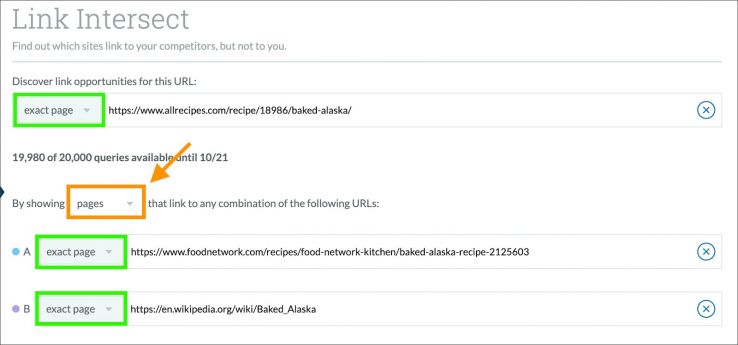

Один из самых простых и эффективных способов поиска донора для проставления обратной ссылки — посмотреть, какие сайты ссылаются на конкурентов, и попробовать разместить свои ссылки на этих же площадках. Сайрус Шепард развивает данную идею, и предлагает искать сайты, которые ссылаются сразу на нескольких конкурентов. Это увеличивает шансы без особых сложностей договориться о размещении и вашей ссылки.

Проводить такой анализ вручную — не самая простая задача, но это умеют делать некоторые инструменты. Автор, скорее всего, не без личной заинтересованности, приводит в пример функционал Moz, в котором есть опция поиска пересекающихся ссылок.

В заключение всего сказанного стоит еще раз напомнить избитую SEO-истину. Ваша задача — не просто вывести страницы в топ, а добиться того, чтобы сайт был «последним кликом» для пользователя. Другими словами, страница должна раскрывать запрос так, чтобы у человека отпала необходимость вернуться на выдачу и продолжить искать. Этого невозможно добиться без качественного контента, который экспертно, исчерпывающе и лаконично раскрывает запрос. В такой связке — качественные статьи + правильная SEO-оптимизация — вы гарантированно подниметесь в рейтинге и получите трафик, которого заслуживаете.