Рейтинг статьи: 5,00

Проседание поискового трафика после смены CMS — стандартная ситуация. То, как быстро он восстановится и восстановится ли вообще — зависит от того, насколько грамотно был реализован перенос на новый движок. Часто веб-мастера сосредотачиваются только на технической стороне переезда, осознанно или по незнанию пренебрегая моментами поисковой оптимизации. О том, какие неочевидные опасности для SEO скрывает переезд на новую CMS, и как обезопаситься от последующих проблем с продвижением — рассказывают и делятся опытом специалисты ArtisanTeam.

Поиск и исправление страниц, отдающих 404-ю ошибку, время от времени полезно проводить на любом сайте. Но после переноса ресурса на новый движок или другой глобальной реорганизации эта процедура становится обязательной. Неправильное изменение урлов (об этом ниже) или же просто некорректный перенос данных может стать причиной настоящего взрыва 404-х страниц.

Для проверки кода ответов мы используем следующую схему. При помощи одного из «пауков» выгружаем со старого сайта все страницы в виде списка урлов. Далее проверяем корректность ответа кода сервера для всех выгруженных url на тестовом домене. Если обнаруживается, что многие из страниц отдают 404 ошибку, наша задача разобраться с причиной такой ситуации и исправить ее.

Примечательно, что эта проблема часто остается незамеченной для глаз программиста, который сосредоточен больше на технических аспектах смены движка. При этом потерянные при переезде страницы могут сыграть фатальную роль для всего продвижения. Задача seo-оптимизаторов — не допустить такого сценария. В нашей практике был показательный случай, когда при проведении SEO-аудита после переноса сайта, мы обнаружили, что у клиента из 1600 страниц 850 url отдавали 404 ошибку. Несложно догадаться, какие перспективы ожидали бы сайт с таким количеством битых урлов.

Пагинация — это порядковая нумерация страниц. Постраничный вывод контента нужен для того, чтобы увеличить скорость загрузки разделов, на которых сосредоточено большое количество информации. Обработка страниц пагинации — это всегда крайне важный фактор внутренней SEO-оптимизации. От нее зависит не только скорость загрузки разделов, но и то, насколько корректно поисковые роботы смогут сканировать сайт.

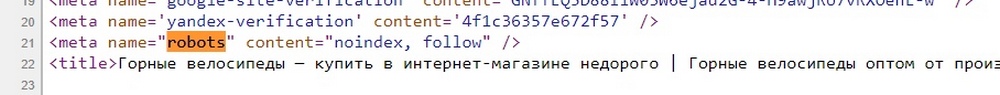

Для поисковых краулеров пагинация зачастую выглядит как дублированный контент. Чтобы обезопаситься от проблем с ранжированием, на таких страницах нужно корректно настроить тег robots (не путать с файлом robots.txt). С помощью noindex из индекса исключают все страницы пагинации кроме первой, но не запрещают роботам переходить по ссылкам на этих страницах. Если такого тега не будет, то страницы 2,3,4… и т.д. будут засчитаны как дубли первой страницы листинга.

Теперь о главном. При переносе сайта на новую CMS настройки тега robots часто слетают. Все страницы пагинации попадают в индекс, и воспринимаются поисковиками как дублированный контент. В лучшем случае это просто затрудняет ранжирование, в худшем — становится фактором пессимизации в выдаче. Поэтому после любой глобальной реорганизации сайта, вебмастер или сео-специалист должны проверять корректность вышеописанных тегов.

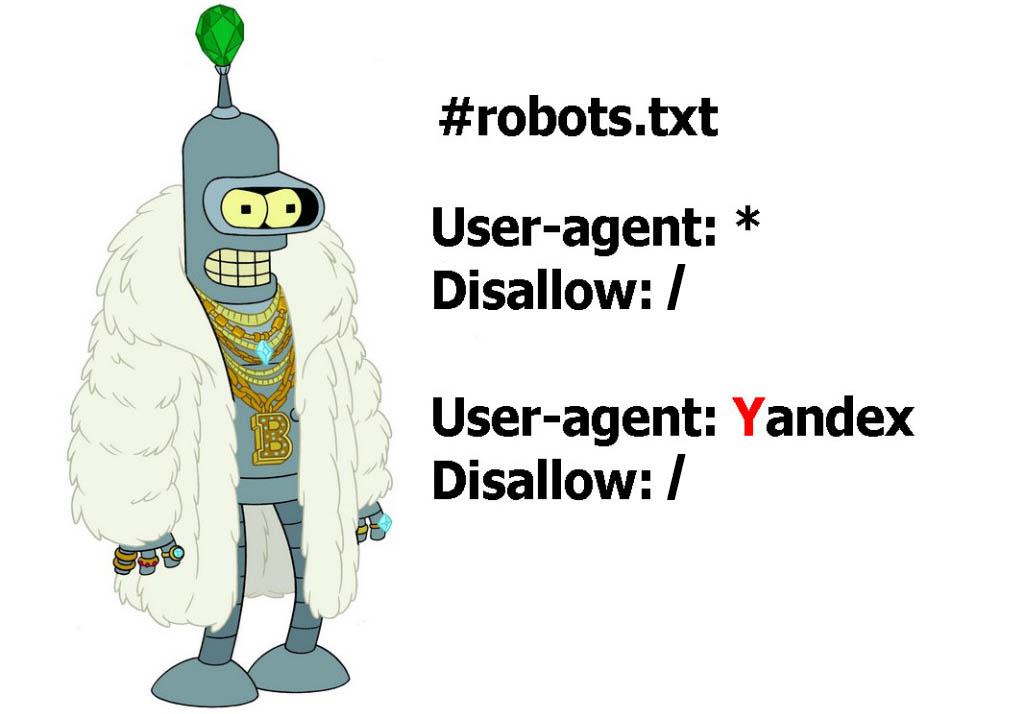

На этапах разработки, редизайна или переноса сайта на новую CMS настоятельно рекомендуем ограничить к проекту доступ поисковых роботов. В таких случаях сайт разворачивают на тестовом сервере, и закрывают его от индексации. Для этого в корне создают текстовый файл robots.txt, в котором прописывают нужные директивы.

Если необходимо закрыть обход всего сайта только для «Яндекса», добавляют директиву:

User-agent: Yandex

Disallow: /

Для запрета индексирования сайта всеми поисковиками (советуем именно такой вариант) прописывают:

User-agent: *

Disallow: /

Работать с «незакрытым» сайтом настоятельно не рекомендуется, т.к. попадание в индекс ненужной информации и тестового «мусора» может навредить поисковому продвижению.

Вам также может быть интересно:

Что самое главное в редизайне, или Почему структура сайта — ваше все

При переносе сайта на новую CMS часто случается так, что на страницах «съезжают» элементы форматирования: меняются заголовки, слетает маркировка списков, тексты выделяются тегом Н2 и т.д. Некоторые из таких изменений особенно коварны, т.к. визуально не имеют отличий, например тег <b>, заменившийся на <h2>. Незаметно это для глаза, но на уровне кода такое форматирование озадачивает поисковых роботов и не сулит ничего хорошего для SEO.

Еще одна потенциальная опасность с точки зрения поисковой оптимизации — это нарушение логической вложенности заголовков. Подобные неприятности часто происходят при редизайне сайта, когда новое оформление нарушает структуру текстовых блоков: H1, Н2 или H3 перестают соответствовать тем текстовым фрагментам, за которыми были закреплены в старой версии.

Переезд сайта всегда требует генеральной уборки в виде технического аудита. Смена CMS приводит к образованию большого количества ссылок, ведущих на страницу с кодом ответа 404 или 410. Для их поиска используют различные автоматизированные инструменты. Во время такой инспекции часто обнаруживают и другие огрехи, например страницы-клоны или целые дублирующиеся каталоги.

При тестировании сайта важно удостовериться, что все изображения сохранили прописанные метатеги, а ссылки, по которым подгружается графический контент, работают. Для интернет-магазинов это особенно важно, т.к. они содержат много картинок, являющихся главным компонентом товарной карточки. Согласитесь, сложно представить покупателя, который будет приобретать товар вслепую. В целом, реорганизация сайта — это удобная возможность провести глобальный аудит изображений: удалить картинки с плохим разрешением, оптимизировать описания под семантику, прописать exif-данные.

Проблема продублированных страниц актуальна для любой реорганизации сайта. Особенно остро она стоит при работе с интернет-магазинами. Это объясняется не только огромным количеством исходных страниц, но и множеством фильтров, сложными рубрикаторами и т.д. Появление дублей во многом зависит от типа используемого движка. Наиболее проблемной CMS в этом вопросе традиционно считается Joomla, это одна из причин по которой от нее стараются отказываться при создании коммерческих сайтов. WordPress — более адекватен, когда речь заходит о штамповке дублей. Для него написано много хороших плагинов, которые позволяют настроить человекопонятные урлы и в автоматическом режиме проставить 301-редиректы, ведущие со старых URL на обновленные.

Корректный URL — важный фактор для поискового продвижения. Реорганизация проекта чаще всего связана с внесением изменений в структуру сайта и последующей обязательной настройкой серверного перенаправления пользователей на другой URL (301-й редирект). Перед прописыванием редиректов уместно провести небольшой аудит, и проверить, насколько урлы соответствуют базовым требованиям поисковых систем:

Информативность. Адрес страницы должен отражать суть запроса: взглянув на название урла, должно быть сразу понятно чему посвящен тот или иной раздел.

Краткость. Лаконичность очень важна для поисковиков. Перегруз урла лишними словами воспринимается краулерами как спам. Пример: /samye-deshevye-gornye-lyzhi/ — с таким URL вы на старте создаете странице большие проблемы для ее дальнейшего продвижения.

Вложенность с ориентацией на спрос. При создании URL интернет-магазинов важно, чтобы иерархия документов соответствовала спросу и конкуренции в коммерческой нише. Другими словами, чем востребованней раздел, тем ближе к корню его нужно располагать.

Корректная транслитерация. Перевод на транслит не всегда подчиняется жестким правилам. Разные движки могут по-своему генерировать названия, что создает сложности при настройке редиректа и требует тщательной проверки. Например, мы имеем урлы /catalog/velosipedy/ и / catalogue /dorognye/velosipedy/, на первый взгляд изменена только структура с добавлением нового подраздела. Но если присмотреться к транслитерации catalog, становится понятным, что настройка такого редиректа окажется пустой тратой времени.

Если магазин существует не первый год, с большой долей вероятности он уже имеет редиректы. Про них часто забывают при переезде на новый движок. Не в последнюю очередь это объясняется и тем, что такие страницы не видны в общей структуре. Таким образом, при смене CMS «за бортом» можно по ошибке оставить страницы, которые имеют немалый вес, много ссылок и генерируют трафик. Этого допускать категорически нельзя. А вот все тестовые документы и другой мусор, образовавшийся в процессе работ, наоборот, нужно тщательно вычистить, чтобы он не попал в индекс.

Вам также может быть интересно:

ТОП-10 браузерных расширений для SEO-оптимизации

Вне зависимости от того сгенерирован файл Robots.txt автоматически или прописан вручную, перед выкатом новой версии сайта его синтаксис нуждается в тщательной проверке. Переезд на новую CMS меняет всю внутреннюю логику сайта. Поэтому перед релизом важно убедиться, что от индексации закрыты все служебные разделы, а все, что должно быть доступным для поисковиков — открыто.

Конечно, это далеко не полный перечень тех мероприятий, которыми завершают перенос магазина на новый движок. Но именно описанные выше ситуации чаще всего ускользают из поля зрения мастеров. В целом это логично, поскольку разработчики всегда сосредоточены больше на технической стороне переезда. Поэтому любые глобальные работы по реорганизации сайта лучше проводить в сопровождении SEO-специалистов, которые не удалят микроразметку как избыточный код, не накосячят с урлами и своевременно укажут на все подводные камни, представляющие опасность для поискового продвижения.