Рейтинг статьи: 2,80

Накрутка поведенческих факторов – далеко не новый прием черной оптимизации, который тем не менее продолжают активно использовать в современном SEO. Проблема накруток так или иначе касается всех вебмастеров, в том числе тех, кто продвигает сайт исключительно белыми методами. Это объясняется тем, что недобросовестные оптимизаторы не только «крутят» активность на своем сайте, но и параллельно скручивают поведенческие факторы у конкурентов. Такая схема остается жизнеспособной по большей части в Яндексе, особенно в коммерческих нишах.

Наравне с накруткой в последние годы для оптимизаторов становится массовой и другая проблема – нагуливание трафика. Здесь также речь идет о нашествии ботов на сайт, но со своим менее вредоносными целями. Даже несмотря на то, что такую активность некорректно называть атакой, «гуляние» ботов ухудшает картину по ПФ и заставляет лишний раз переживать владельцев сайтов. В этом материале мы поговорим о том, как конкуренты скручивают поведенческие 2021 году и как своевременно обнаруживать такие атаки. Отдельно уделим внимание теме нагуливания куки и отличиям такой бот-активности от скручивания ПФ.

Накрутка поведенческих факторов – это SEO-манипуляция, при которой роботы имитируют действия реальных пользователей на сайте. Таким способом они пытаются ввести поисковики в заблуждение, заставляя их думать, что сайт интересует и вовлекает «живую» аудиторию. За счет такой фейковой активности ресурс быстро поднимается в выдаче, поскольку поисковики традиционно отдают преимущества сайтам с хорошими поведенческими: низкими показателям отказов, большой глубиной просмотра и продолжительными сеансами.

Чаще всего сайты крутят для того, чтобы искусственно завысить позиции в выдаче. Но не только. Поскольку речь идет о запрещенных приемах оптимизации, за которые наказывают поисковики, накрутки используют в том числе чтобы пессимизировать сайты конкурентов. Нередко эти два эффекта сочетают: «продвигая» свой сайт ботами, попутно ими же топят конкурентов.

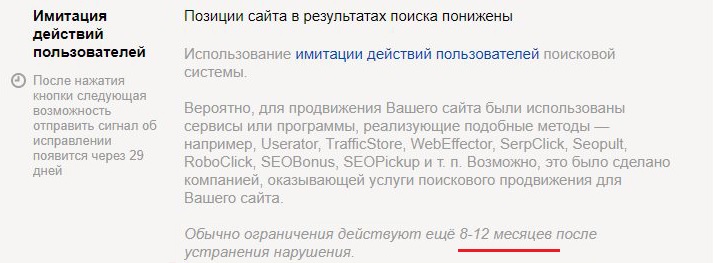

Отдельная категория накрутчиков – недобросовестные SEO-подрядчики, которые искусственно завышают метрики эффективности, имитируя результативность своей работы. Естественно, пускать пыль в глаза таким образом получается недолго, поскольку взрывной прирост трафика на сайт никак не связан с увеличением роста продаж или конверсий. При этом последствия такой имитации могут оказаться фатальными: в лучшем случае онлайн-бизнес придется поставить на паузу в среднем на 8-12 месяцев.

Накрутку производят из поиска, заставляя ботов переходить на сайт из выдачи по конкретной фразе или группе запросов. В большинстве случаев логика и механика накруток выглядят приблизительно следующим образом.

Берут сайт, у которого нулевая или очень плохая видимость в поисковых системах по целевым запросам. Обычно это дропы и реже — сайты-новореги.

↓

Сначала накрутчики натренировывают ботов на то, чтобы они искали в поиске нужный сайт (как правило, это делают через брендовые запросы), переходили на него и имитировали активность вовлеченных пользователей: делали доскроллы страниц, осуществляли внутренние переходы и т.д.

↓

Так довольно быстро сайт выводят в топ 30-50 по нужной группе запросов. С этого момента меняют тактику. Теперь боты параллельно скручивают поведенческие на всех сайтах, которые занимают более высокие позиции. Как правило, это делают за счет возвратов на поиск. В общих чертах это выглядит примерно так: бот вводит целевой запрос, переходит по каждому сайту в выдаче и быстро покидает его пока не докликает до своей площадки. На ней робот уже эмулирует более качественные ПФ.

Схемы накруток могут варьироваться. Иногда ботов дополнительно затачивают на кликфрод. Они не просто пессимизируют чужие сайты за счет быстрых возвратов на поиск, но и попутно скликивают контекстную рекламу конкурентов. Одновременно с этим продолжают существовать и точечные атаки, когда с помощью накруток пессимизируют конкретные сайты. Все это делают это при помощи специальных сервисов. В плане реализации они, действительно, серьезно шагнули вперед. С их помощью можно создавать сложные сценарии псевдопользовательского поведения, при этом сами боты технически реализованы так, что не засвечиваются перед поисковиками.

Естественно, все это мы рассказываем не как руководство к действию. Понимание актуальных принципов черного SEO в первую очередь должно развеять заблуждение о том, что накрутками топят только крупных конкурентов. Описанный выше механизм дает понять, что под атаку могут попасть даже те сайты, которые занимают весьма скромные позиции по целевым запросам. Именно поэтому каждому вебмастеру нужно отслеживать метрику и уметь идентифицировать вредоносную бот-активность.

В выдаче Google накрутки не дают заметного результата. Для сторонников белых методов продвижения это, безусловно, большой плюс, поскольку недобросовестные конкуренты ограничены в способах воздействия. Алгоритмы очень хорошо распознают релевантность всей поисковой активности и просто не учитывают подозрительный трафик. Вместе с тем в Google формально нет санкций за накрутку поведенческих. Другими словами, риски за SEO-манипуляции минимальные, но и эффект от таких действий здесь стремится к нулю. По крайней мере, так обстоят дела в русскоязычной выдаче Google.

В Яндексе ситуация сильно отличается. Несмотря на апдейты 2020 года, накрутки здесь по-прежнему продолжают давать эффект. Они хоть и стали работать слабее, но их активно используют как для продвижения в выдаче, так и для пессимизации конкурентов. Наказываю за такую активность в Яндексе тоже более серьезно. За накрутки могут прилетать скрытые или открытые санкции. В первом случае происходит вылет лишь по части запросов, при этом в Вебмастере нет никаких уведомлений, а о наложении санкций можно догадаться только по частичному падению трафика. В случае с открытыми санкциями вебмастер получает страйк на 8-12 месяцев – сайт вылетает из поиска по всем запросам, что по эффекту сравнимо с баном на уровне хоста. Другими словами, почти на год можно забыть о каком-либо трафике из Яндекса.

Для онлайн-бизнеса, который генерирует конверсии через органический поиск, такой сценарий сравним с катастрофой. В лучшем случае придется рассчитывать только на трафик из Google, в худшем (если переходы были по большей части из Яндекса) – искать или развивать альтернативный канал трафика.

Выше мы описали общую логику накруток. Ее фундаментальные принципы остаются неизменными много лет, но на уровне технической реализации все сильно поменялось. Продолжается своего рода непрекращающаяся игра в кошки-мышки между поисковыми алгоритмами и черными оптимизаторами, которые придумывают более утонченные схемы. Какой бы изощренной ни была накрутка с точки зрения своей технической реализации, ее всегда можно обнаружить при помощи внимательного изучения данных систем аналитики. Обычно выводы о манипуляциях с ПФ делают на основе анализа следующих факторов.

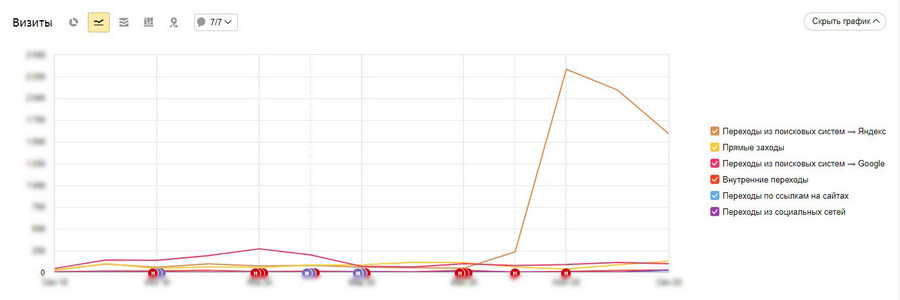

Если сайт хотят пессимизировать, его будут накручивать через поиск. Поэтому при нетипичном росте трафика первым делом смотрят, какой канал и какая поисковая система генерировала переходы на сайт. Как правило, откручивают через какую-то одну ПС, и в большинстве случаев это именно Яндекс.

Даже самые резкие скачки трафика сами по себе еще не позволяют говорить о том, что сайт накручивают. Это может быть результатом других, менее вредоносных, бот-активностей. Если речь, действительно, идет об атаке конкурентов, рост переходов будет коррелироваться с резко взлетевшим числом отказов.

В Яндекс.Метрике по умолчанию за отказ засчитывается любой сеанс, длительностью менее 15 секунд. Отдельно отметим, что в Google Analytics механика подсчета отказов другая. Как уже было сказано выше, именно через отказы и быстрый возврат на выдачу конкуренты скручивают поведенческие, создавая имитацию того, что пользователь недоволен качеством сайта. Таким образом, аномальный рост посещений в связке с взлетевшими отказами – повод насторожиться и более внимательно изучить метрику.

В первую очередь в отчете «Отказы» нужно посмотреть корреляцию с источниками переходов. Как уже было сказано, в большинстве случаев идут из одной поисковой системы. В отчет Метрики можно добавить и другие важные группировки, которые помогут сделать выводы о «естественности» отказов за выбранный период. В первую очередь нужно посмотреть следующее:

Проанализировав этот массив информации, можно сделать более-менее точные выводы о естественности трафика, который генерировал плохие ПФ. Отдельно отметим, что рост показателя отказов далеко не всегда связан с происками конкурентов. Он может обуславливаться разного рода ошибками и техническими недочетами на сайте. Больше об этом – читайте в отдельной статье:

Высокие отказы на сайте: находим причины и оптимизируем страницы

Нетипичная география переходов – еще один маркер, по которому можно определить плохо организованную атаку. Накрутчики вынуждены использовать прокси-сервера, и очень часто они не соотносятся с гео сайта, на котором скручивают ПФ. Это особенно хорошо прослеживается в eCommerce, когда магазин имеет четко очерченный региональный трафик, и вдруг на него начинается волна переходов из совершенно нерелевантного гео.

Иногда бывает не лишним проверить статистику запросов по Wordstat. Если вы видите, что на сайт идут по фразам, частотность которых не соответствует данным официальной статистики – это еще один повод проявить осмотрительность. Например, если по запросу переходит 300 человек в сутки, в то время как по Wordstat это его частотность за месяц.

Иногда не будет лишним обратить внимание на ряд дополнительных моментов. При аномальном изменении метрик фиксируют нетипичный рост трафика из подсетей, пользующихся плохой репутацией. Если для накрутки используют не ботов, а реальных людей (такое тоже бывает), локализовать вредоносный трафик иногда получается по рефереру в той же Яндекс.Метрике.

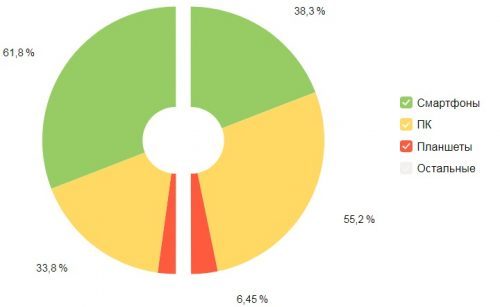

Резкое изменение в соотношении типов устройств – еще один маркер потенциальной накрутки. Например, если сайт собирает по большей части визиты с ПК, но одновременно с волной отказов на него пошел трафик со смартфонов.

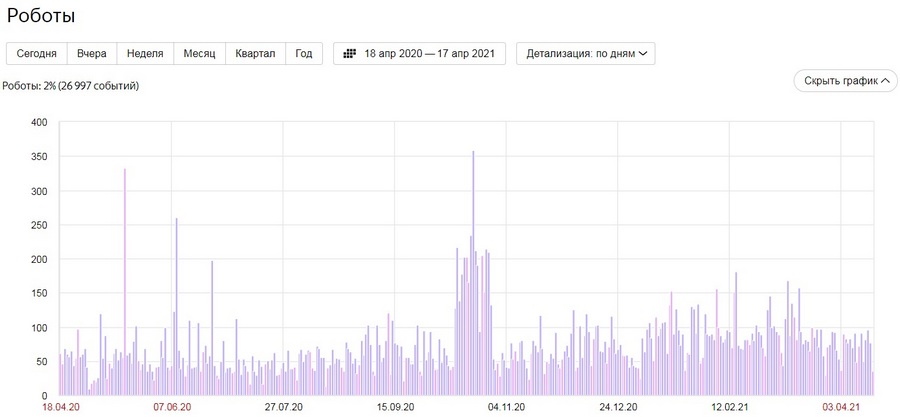

В штатных системах веб-аналитики присутствуют функции, позволяющие отслеживать искусственный трафик. Поскольку мы говорим в большей степени о Яндексе, как ПС с которой накручивают чаще всего, рассмотрим, как эта опция реализована в Метрике.

Отчеты → Стандартные отчеты → Мониторинг → Роботы

В этом отчете представлены данные об активности роботов, которые совершали визиты. Сегодня бот-трафик – вполне обыденная вещь для любого сайта. Его активно генерируют те же самые поисковые системы, всевозможные мониторинговые боты, краулеры сервисов для проведения аудита и т.д. Это условно хорошие боты. Наравне с ними существует плохой автоматизированный трафик, который создают веб-парсеры, спам- или DDoS-боты.

Все эти боты преследуют свои сугубо технические цели и не заинтересованы в глубокой конспирации перед поисковыми системами. С накруточным трафиком все обстоит иначе. Здесь приоритетная задача – в точности смоделировать поведенческие характеристики живых людей. Современные автоматизированные решения справляются с этим более чем успешно, за счет многоуровневой технической маскировки. Боты эмулируют IP, типы устройств, расширения экрана, подменяют реферер и т.д. Поэтому, если накрутка произведена не совсем топорно, такой трафик обычно не распознается Я.М как роботный. Тем не менее, этот отчет необходимо всегда задействовать при анализе подозрительных активностей.

Поисковые системы, и в первую очередь Яндекс, с 2020 года стали заметно эффективнее определять накрутки и бороться с ними. Если манипуляции осуществляет не сам владелец сайта или его SEO-подрядчик, переживать не стоит. По крайней мере в этом каждый раз стараются убедить «платоны» Яндекса. На деле все несколько иначе, и негативные последствия от накруток конкурентов все же возникают. Как защититься в таком случае? Сразу скажем, однозначно эффективного способа или какого-то решения из коробки для этого нет.

Проседание позиций от накруток сильно зависит от того, какие у сайта текущие поведенческие. Если мы говорим об относительно молодом ресурсе, с еще непрокачанными ПФ, или о сайте, у которого поведенческие и без конкурентов далеки от идеала, то последствия от накруток будут серьезными. Они могут легко улететь за пределы топ-100 по скрученным запросам. Сайт с высокими показателями трафика и сильными поведенческими пессимизировать намного сложнее. Исходя из этого наиболее работающий способ противодействия накруткам – наращивание трафика с хорошими показателями вовлеченности, который будет укреплять ПФ сайта. Эта стратегия беспроигрышная и для Яндекса, и для Google.

Что касается более быстрых и простых методов борьбы с накрутками, то здесь вебмастерам остается использовать только стандартные способы. Впрочем, их эффективность вызывает неоднозначные мнения в профессиональном сообществе. Одна из классических механик – идентификация предполагаемого вредоносного трафика и его фильтрация через блокирование отдельных IP или целых подсетей. Недостатки этого метода очевидны. Первое, это низкая эффективность, если мы говорим о фильтрации через IP или блокировке по user agent. Вторая проблема – это единовременное отсечение большого массива переходов, среди которых, как ни крути, будет часть здорового трафика. При этом, когда мы говорим о блокировке накруточного трафика, здесь остается открытым вопрос: как на это отреагируют поисковики. Если накрутки дают негативный эффект, то можно предположить, что такой трафик воспринимается ПС, соответственно, его блокировка будет вызывать вопросы.

У блокировок есть и другой более весомый недостаток. При такой защите отказы не будут учитываться на стороне сайта, но будут фиксироваться на уровне браузера. Информация отсюда также подтягивается поисковикам и учитывается в процессе ранжирования наравне с данными Метрики и предположительно сведениями из других источников (например, некоторых яндексовских сервисов). Другими словами, от возвратов на выдачу (а это основной пессимизирующий механизм накрутки) такая схема не защищает.

Отсюда вытекает и ответ на вопрос, что будет, если просто не подгружать потенциальным ботам код Метрики. Статистика в отчетах станет чище, но негативный эффект от накруток сохранятся, поскольку Яндекс будет получать сигналы о плохих ПФ на уровне браузера. Поэтому блокировки и скрытие счетчиков лишают проблему накруток лишь отчасти. При использовании сервисов CloudFlare и прочих аналогов, обеспечивающих фильтрацию ботов, сохраняется тот же эффект. Они более или менее защищают от скручивания посткликовых ПФ, но не противодействуют возвратам на выдачу. Из преимуществ – отчетность в Метрике станет чище.

Таким образом, пока Яндекс не доработает свои алгоритмы хотя бы до уровня Google, накрутчики будут досаждать тем, кто старается работать по-белому. Насколько б не были пылкими дискуссии между оптимизаторами в этом вопросе, на сегодняшний день не существует однозначно эффективной защиты от накруток. Наиболее надежный способ противодействия в этом случае – привлечение на сайт качественного органического трафика, который будет естественным образом прокачивать посткликовые ПФ сайта. Ну и, конечно, «платоны». Несмотря на однотипность их отписок с уверениями, что все под контролем, уведомить поддержку Яндекса в таких случаях все же нужно. Для лучшей убедительности не забудьте приложить скрины из Метрики.

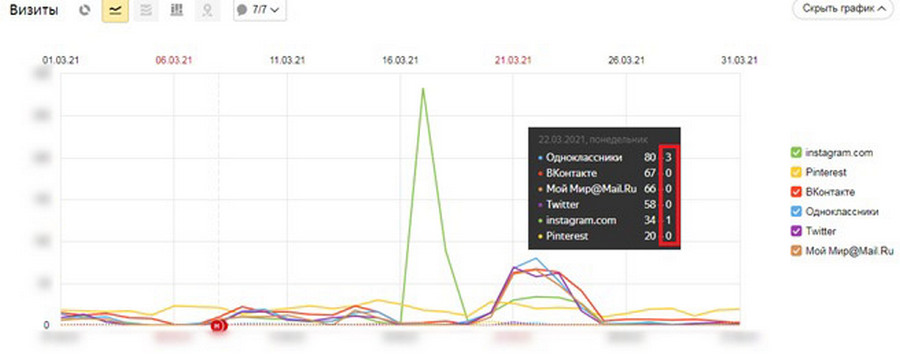

Последние несколько лет многие оптимизаторы стали отмечать на своих сайтах странный бот-трафик, с нетипичной для накрутчиков моделью поведения. Волна такой активности продолжается по настоящее время. В отчетах Метрики это обычно выглядит как взрывной рост визитов без возврата на выдачу. Чаще всего это массовые переходы из соцсетей или другой type-in трафик. Боты волной заходят на сайт и ведут себя как реальные пользователи: эмулируют скроллинг, движения мыши, делают переходы по ссылкам. В большинстве случаев это роботы, целью которых является не пессимизация сайта, а прокачивание своей «человекообразности» перед поисковыми системами. Метрики роботности, как правило, никак не реагирует на такие визиты.

Другими словами, нагуливание cookie – это прогревание бот-профилей, с целью скрыть свою роботность перед поисковыми алгоритмами. Посещая сайты, боты накручивают cookie, формируют кэш и со временем начинают выглядеть для поисковиков как профили живых людей, со своей историей поиска, краткосрочными и долгосрочными интересами. В дальнейшем такие профили используют для регистраций на всевозможных сервисах или для все тех же вредоносных накруток. Нагуливанием занимаются в масштабах целых ботоферм, отсюда и массовый характер набегов на сайты.

Как уже было сказано, такие визиты далеко не всегда распознаются как роботные, а уходят в общую статистику. По крайней мере, так обстоят дела в Метрике. Если нагуливание происходит систематически, это сильно искажает реальные данные по сайту и заставляет переживать за сохранность текущих позиций.

При аномальном всплеске визитов сразу из нескольких соцсетей метрики роботности фактически никак не реагируют

Как видно, в случае с нагуливанием полагаться на отчет «Роботы» не приходится, поэтому вебмастерам важно самим внимательно следить за данными Метрики и замечать всю аномальную активность. От обычного скручивания ПФ такой бот-трафик отличают следующие признаки:

– Резкий прирост type-in трафика, волна переходов из социальных сетей или рекомендательных систем. Вместе с тем существуют модели нагуливания через поисковые запросы, но по общим наблюдениям их используют редко.

– Непродолжительность визитов. Как правило, крутят в течение одного дня. Реже – на протяжении двух-трех дней, но с меньшей интенсивностью.

– Низкий процент отказов. Здесь все понятно, приоритетная задача такой накрутки – эмуляция реальных сессий.

Отталкиваясь от этих особенностей можно сделать выводы, что сайт используют не для скрутки поведенческих, а для «очеловечивания» ботов. Тем не менее, главный вопрос остается открытым: чем чревата для позиций сайта такая активность. По общим наблюдениям, негативный эффект от нагуливания, если и есть, то незначительный. На своих проектах, мы не наблюдали каких-либо выраженных негативных последствий. Конечно, любой набег ботов — это повод проявить осмотрительность.

Зафиксировав факт таких накруток, первым делом определяют, на какие URL шел трафик. После этого анализируют как изменилась динамика по всему хосту, так по конкретным URL. Зачастую какие-либо негативные последствия от таких визитов отсутствуют: трафик ни падает, ни растет. Но если за накруткой последовал спад посещаемости, имеет смысл проверить изменение позиций. При обнаружении прямой зависимости между просадкой и нашествием ботов все что остается – попробовать написать «платонам» и надеяться на восстановление позиций. Мы не имели подобного опыта, но, по отзывам некоторых оптимизаторов, такое иногда срабатывает.