Рейтинг статьи: 4,80

Контент крадут у всех. Это данность, которая всегда была свойственна интернету. Те, кто думают обратное, и уверены в неприкосновенности содержимого своего сайта — текстов, оригинальных картинок, кода и пр. — либо ошибаются, либо их сайт еще очень молодой и пока (!) не интересует копипастеров. Данные всегда парсили, и будут парсить. Защититься от этого на 100% невозможно. Как же быть в таких случаях?

Лучшее противодействие воровству контента — ваша осведомленность. Вы должны знать, во-первых, что и как парсят. Во-вторых, своевременно замечать, когда украденные данные начинают вредить вашему сайту, прежде всего, когда проседают позиции в поиске. В-третьих, важно научиться играть на опережение и защищать свои данные. И, наконец, когда ваш контент украден, нужно уметь грамотно решать эту проблему. При всех сложностях противодействовать копипастерам — вполне реально. Теперь обо всем этом по порядку.

Парсинг, или скрапинг, — это сбор данных с чужих сайтов. Не вдаваясь в технические нюансы, суть этого процесса можно описать так: специальные боты посещают страницы целевого ресурса, выгружают HTML-код, разбирают его на отдельные составляющие, вычленяют нужные данные и сохраняют их в своей базе. Зачастую боты обходят сайты на регулярной основе, отслеживая изменение цен, расширение товарного ассортимента или публикацию нового контента, который можно украсть.

Поисковые роботы Google и Яндекса — это тоже своего рода парсеры. Принцип их работы аналогичен: они периодически совершают обход сайта, собирают информацию и индексируют новые документы. Этим объясняется главная сложность противодействия парсингу: защищаясь от ботов-шпионов очень легко заблокировать содержимое сайта для краулеров Google и Яндекса. А это — прощай SEO и трафик из поиска, за счет которого живут все нормальные сайты.

Со стороны сервера запросы пользователей и роботов выглядят одинаково. Из этого вытекает, что если живые люди могут получить доступ к сайту, то его содержимое доступно и ботам. Соответственно, большинство автоматизированных средств против парсинга в той или иной мере работают и против пользователей. На практике это выливается в то, что антипарсинговые решения существенно ухудшают опыт пользования сайтом и просаживают поведенческие, что не лучшим образом сказывается на SEO.

Не ботами едиными

Говоря о парсинге и краже данных не следует забывать, что помимо использования скриптов контент не менее успешно копипастят руками. Как правило, это касается копирования текстов и фото. Формально копипаст не подпадает под определение парсинга, но последствия для SEO от такого заимствования аналогичны.

Текстовый контент

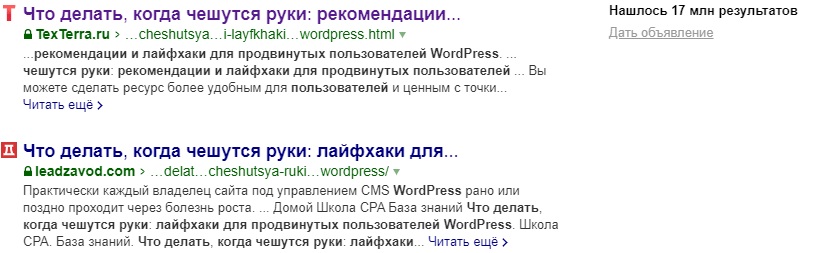

Это то, что интересует большую часть злоумышленников, т.к. тексты были и остаются основой поискового продвижения. Формально, даже если вашу статью украли, Google и Яндекс умеют определять сайт-первоисточник и отдавать ему преимущество при ранжировании. Но так бывает далеко не всегда. Например, если трастовые ресурсы крадут контент у молодых сайтов — последние могут остаться в пролете.

Статьи иногда перехватывают и публикуют на сторонних ресурсах до того, как они попадают в индекс. Такой перехват зачастую реализуют при помощи специальных скриптов. При подобном сценарии сайт, который украл текст, вовсе выглядит для поисковиков как первоисточник, и доказать свое право на контент — практически нереально.

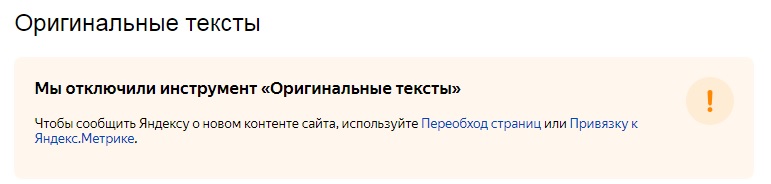

До недавнего времени ощущение безопасности веб-мастерам обеспечивал инструмент «Оригинальные тексты» в панели Яндекс.Вебмастер. Предполагалось, что если загружать в него статьи перед публикацией, в случае кражи, поисковик будет на вашей стороне. Но с недавнего времени Яндекс отключил и этот инструмент, предложив использовать «Переобход страниц» или «Обход по счетчикам Метрики». Эффективность этих механизмов по-прежнему вызывает много вопросов.

Семантика

Когда страницы сайта оказываются в топе, конкурентов начинает интересовать, как именно они туда попали. Их задача: узнать, под какие ключи оптимизированы статьи, какова их плотность, характер вхождения — все это также легко узнать. При помощи нужного софта это делается буквально в несколько кликов, причем одинаково просто спарсить как ключи для статьи, так и семантическое ядро всего сайта.

Метатеги и заголовки

Грамотная оптимизация <title>, <description>, заголовков <h1>-<h6> — факторы, во многом определяющие высокие позиции в выдаче. Можно тщательно прорабатывать эти атрибуты, экспериментировать с семантикой и нащупывать самый работающий вариант, а можно — в несколько кликов спарсить метаданные из топа выдачи. Причем для этого не нужен какой-то уникальный софт: парсить эти атрибуты умеют все более или менее серьезные SEO-анализаторы.

Цены и товары

Здесь, думаем, все понятно. Это отдельная eCommerce история, при помощи которой магазины конкурируют друг с другом. Как правило, такой скрапинг осуществляют на постоянной основе, отслеживая обновления каталога и цен.

Дизайн или отдельные элементы кода

Спарсить могут весь сайт или его конкретные элементы, например, какой-то оригинальный функционал. Обычно поисковики жестко пресекают такие финты, и у недоброжелателя нет шансов обойти вас в выдаче с клонированным ресурсом.

Первый и самый очевидный ответ — конкуренты, которым не дает покоя ваше пребывание в топе. Но ими дело не ограничивается. Парсинг сайтов находит применение для очень широкого спектра задач. Естественно, в 90% случаев — это черное SEO, и вот куда обычно уходит ворованный контент.

1. Наполнение дорвеев.

2. Генережка контента под глобальные PBN-сети. Что такое PBN — читайте здесь.

3. Парсинг текстов для создания WEB 2.0.

4. Скрапинг контента для сайтов, на 100% продвигающихся за счет генережки; в топ такие ресурсы вывести сложно, но они могут вполне нормально ранжироваться и иметь позиции в выдаче. По крайней мере такое часто встречается в русскоязычном поиске Google.

5. Парсинг описаний для товаров. Может для кого-то это станет откровением, но карточки с неуникальными описаниями очень хорошо ранжируются поисковиками. Вполне вероятен сценарий, что вас обойдут в выдаче, используя ваши же уникальные тексты для товаров.

Как видно, переживать за сохранность своих данных нужно всем: даже если вы продвигаетесь в нише без конкурентов (чего не бывает) или они белые и пушистые (что тоже нонсенс). Примерно 2/3 всего парсинга в Сети — это полностью автоматизированный процесс. То есть, вас не будут искать и копипастить данные вручную — все это сделает скрипт, как только ваши страницы попадут в топ или станут более-менее заметными.

В зоне риска прежде всего оказываются тексты — они представляют наибольший интерес для парсеров и на их защите следует сосредотачиваться в первую очередь.

Итак, кража статей — это данность. И если не сейчас, то в будущем с этим обязательно столкнется каждый веб-мастер. Контент нужно защищать, причем не ждать пока ваш ресурс станет популярным и с него начнут активно копипастить. Молодые сайты находятся в особенно уязвимой ситуации, т.к. когда у них заимствуют контент более трастовые площадки, поисковые системы могут приписать право первоисточника им. Теперь — о способах защиты: эффективных и не очень.

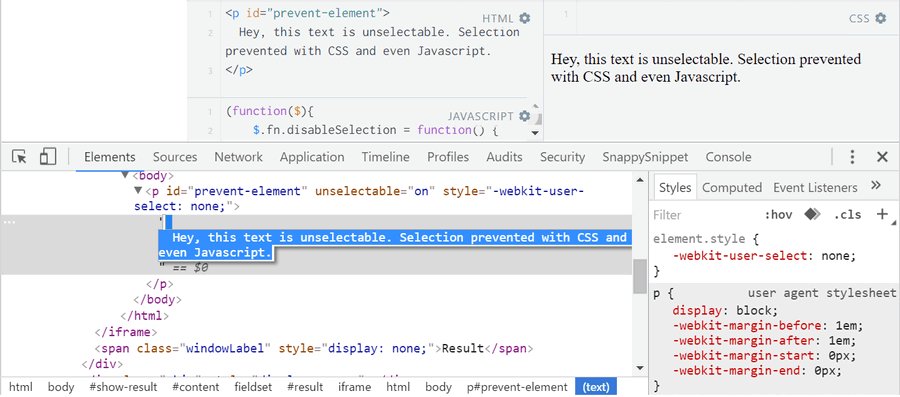

Запрет на выделение текста

Вы можете создать отдельный CSS-стиль, запрещающий выделение текста. Речь идет о небольшом микрокоде, с которым легко разобраться самому или поручить эту задачу программисту. Такое решение нельзя назвать полноценной защитой, поскольку текст можно извлечь из HTML-кода. Это лишь немного усложнит жизнь копипастеру, и то не всегда. Не забываем, что руками копируют очень редко, а этот способ не создает никаких преград для парсинга. Даже если кто-то не слишком опытный захочет забрать ваш текст, он погуглит как это сделать через код (спойлер: это совсем несложно).

Запрет на копирование в буфер обмена

Механизм этой защиты несколько иной. На сайт добавляют небольшой скрипт, который разрешает копирование текста, но не позволяет вставить его в буфер обмена. В остальном эффективность этой защиты такая же низкая, как и в первом случае. Она не защищает от парсинга, и может обезопасить только от неумелых копипастеров, которым лень сходить в поисковик и узнать, как извлечь текст через код.

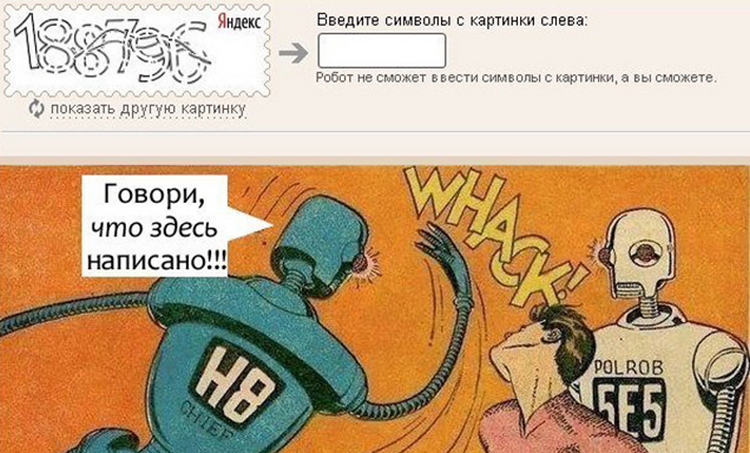

Подключение reCAPTCHA

Сервис reCAPTCHA и всевозможные аналоги дают крайне низкую эффективность при защите от парсинга и спама. В профессиональных кругах их упоминание успело стать моветоном. Решений по обходу капч очень много. Если не вдаваться в детали, работают они следующим образом: когда защита запрашивает проверку, капча автоматически перенаправляется на сторонний сервис, где ее распознает реальный человек и отдает обратно на сервер.

Услуги по обходу капч стоят в прямом смысле копейки (можете сами посмотреть тарифы на 2Captcha или ruCAPTCHA). Поэтому те, кто пишет парсеры, даже не рассматривают капчи как какую-то проблему. А вот для реальных пользователей — это зло. Закрывая контент капчами, будьте готовы к возможным лагам с индексацией и гарантированной просадке поведенческих. Все это нанесет неизбежный удар по SEO. Чтобы смягчить негативный эффект от капч можно использовать скоринг и задействовать черные списки, это несколько улучшит пользовательский опыт, но не решит главной проблемы — при желании на вашем сайте спарсят все, что нужно.

Использование DMCA protected

Речь идет о специальном сервисе мониторинга контента. При подключении его к сайту (не бесплатно), он периодически совершает обход, и проверяет страницы на предмет появления копий. Если данные кто-то украл, на почту придет уведомление. За дополнительную плату представители сайта готовы писать абузы, чтобы Google удалил скопированный текст из выдачи. Вплоть до судебных разбирательств. Сайт, находящийся под защитой этого сервиса, получает сертификат и специальную плашку, которая в теории должна отпугивать копипастеров. У нас DMCA protected вспоминают нечасто, но на западе он пользуется довольно большой популярностью.

На практике эффективность такой защиты вызывает много вопросов. Начнем с того, что сервис DMCA protected — это не официальный представитель органов американской юстиции. Звучное название сайта dmca.com многих вводит в заблуждение, т.к. напрямую ассоциируется с законом DMCA, контролирующим авторское право в Сети. Сервис официально никак не связан с органами американской юстиции — это первое. Думать, что плашка в футере будет отпугивать воров — также весьма наивно. Если более или менее опытный злоумышленник захочет по-тихому увести контент или другие данные, он просто удалит на сайте фрагмент защитного кода, и возьмет то, что нужно.

Блокировка ботов по IP

Это один из способов противодействия парсингу, когда данные крадут постоянно и, как правило, в большом объеме. Здесь речь идет уже не только о текстах, но и других сведениях, представляющих стратегический интерес для конкурентов (об этом говорилось выше). Блокировка IP-адресов ботов, которые скрапят ваши страницы,— один из самых распространенных механизмов защиты. Но здесь важно понимать: если вам дорого трафик из поиска, вы вступаете на тонкий лед. Угробить SEO в этом случае — проще простого.

Хорошо написанный парсер весьма убедительно имитирует активность живого пользователя. Благодаря рандомизации заголовков, постоянной смене прокси (поддельных IP-адресов) и другим техническим уловкам отличить бота-шпиона от реального пользователя — очень трудно. Конечно, сервисы для защиты от парсинга тоже становятся более прокачанными, но их основной механизм остается неизменным — это блокировка вредоносных запросов по IP. Продолжается своего рода извечная игра в кошки-мышки между ботами и антипарсерами.

Защищаясь от парсинга, сайт может оказаться заблокированным для краулеров Google и Яндекса, которые являются такими же ботами, но со своими «белыми» задачами. К слову, обычно боты-шпионы представляются на сервере именно краулерами поисковиков. Последствия такого провала очевидны: сайт частично или полностью вылетит из индекса — и прощай органический трафик. Об этом важно не забывать, самостоятельно закрывая сайт от ботов, устанавливая скрипты от парсинга или заказывая самописную защиту.

Добавление ссылки при копировании текста

Этот весьма простой способ защиты может принести немало пользы. На сайт внедряют небольшой скрипт, который автоматом привязывает к скопированному тексту ссылку на источник. Обычно она располагается внизу. Как ни странно, но такие ссылки убирают не всегда: иногда сознательно, иногда по недосмотру.

Стандартный скрипт лучше допилить, и сделать так, чтобы ссылка добавлялась внутри текста. В этом случае вероятность, что ее не заметят увеличивается в разы. Это способ хорош как для защиты от ручного копирования, так и от скрапинга. Он хоть и не препятствует фактической краже, но позволяет узнать, кто скопипастил текст без прогонки статей через антиплагиатчик. Для этого достаточно посмотреть обратные ссылки на свой сайт.

Использование скрипта автозамены символов

Весьма эффективный способ противостоять краже текстов. Его суть состоит в интеграции специального java-скрипта, который при копировании заменяет часть кириллических символов на латиницу — текст становится нечитаемым. Чтобы пофиксить это на уровне кода, нужны специальные навыки, и далеко не каждый копипастер будет с этим разбираться. Данный лайфхак защищает главным образом от ручного копирования. Ботам же все равно: обычно они парсят для автонаполняемых сайтов, где тексты никто не проверяет.

Брендирование контента

Это своего рода аналоговый способ защиты текстов. Его суть проста: статьи нужно делать более персонализированными, писать от лица бренда и чаще упоминать его название, причем делать это так, чтобы бегло подчистить текст было как можно сложнее. Такой контент отсеет часть копипастеров: конечно, наиболее переборчивых и тех, кто ворует вручную. Если вас парсят боты, им это не помещает. Но и тут у вас будет преимущество: можно узнать о перепубликации контента при помощи Google Alerts, настроив оповещение на бренд. Больше об этом и других способах обнаружения кражи текстов мы рассказывали в отдельной статье.

Первым делом свяжитесь с админами площадки и попросите удалить контент. Запугивание судами в рунете воспринимают несерьезно. Поэтому просто напишите, что у вас есть очевидные доказательства принадлежности текста вам, и когда вы подадите абузу в DMCA — она будет рассмотрена в вашу пользу. Часто это работает. Но лишь в тех случаях, когда вас обокрал худо-бедно белый или серый сайт. Если вас спарсили дорвеи, порносайты или другие треш-ресурсы из 100% черной ниши, надеяться что отреагируют — не имеет особого смысла.

Второй шаг — написать в саппорт Яндекс.Вебмастера и Google Search Console. Это особенно актуально, если у вас спарсили весь сайт или копипастер обошел вас в выдаче с вашим же контентом. Сразу скажем, что на быстрый и результативный отклик рассчитывать обычно не приходится. Особенно тяжелой на подъем является служба поддержки Google. Но связываться с саппортом в таких случаях нужно обязательно.

На международном уровне наиболее действенный механизм правовой защиты контента — закон DMCA (Digital Millennium Copyright Act). Он работает в США и распространяется на все американские компании, в том числе поисковики: Google, Bing, Ask. По понятным причинам всех в первую очередь интересует Google. Если вы докажите факт нарушения авторских прав, страницы копипастера удалят из выдачи. Подать жалобу на украденный контент могут в том числе нерезиденты США.

Как это работает на практике? Владелец сайта подает заявку о нарушении авторских прав. В отличие от техподдержки, Google реагирует довольно быстро: присылает ответ и обычно сразу скрывает из выдачи страницы с украденным контентом. Администраторам сайта, на который написана абуза, высылается соответствующее уведомление.

Это идеальный сценарий. Но им обычно все не заканчивается. За владельцем сайта, которого обвиняют в плагиате, остается право подать встречное уведомление. И этой возможностью, как правило, никто не пренебрегает. Тогда доступ к удаленным страницам восстанавливается и начинается долгая волокита. В теории она предполагает судебные тяжбы, но на практике чаще всего, заканчивается ничем.

Жалоба в DMCA отлично работает, когда ваши материалы спарсили дорвейщики. Такие страницы Google обычно блокирует без колебаний. Больше шансов, если контент украл порносайт, автонаполняемый статейник или другой сомнительный ресурс. В остальных случаях вашу жалобу будут парировать встречным уведомлением, прекрасно понимая, что реальное судебное разбирательство, скорее всего, не грозит.

Это еще один весьма действенный способ решить проблему, связанную с кражей данных. Конечно, за спорную статью вряд ли кто-то накажет копипастера, но если речь идет о систематическом копировании контента, хостер, дорожащий своей репутацией, может забанить такой домен. Другое дело, что большинство откровенно мутных сайтов, типа дорвеев или автонаполняемых PBN-сетей, специально разворачивают на абузоустойчивых хостингах. Достучаться с жалобой до провайдера в этом случае — нереально.

Если речь идет о крупном воровстве данных, можно проявить настойчивость и пойти еще дальше, написав жалобу в ICANN. Это всемирная корпорация, которая координирует систему присвоения доменных имен. Формально она не управляет содержимым в Сети, но через нее можно подать жалобу на домен, когда сайт занимается противозаконной деятельностью или злоупотреблениями.

Добиться блокировки домена этим способом реально, если вам досаждают откровенно «черные» сайты, которые уже многократно приводились в пример. Но и в этом случае подача жалобы предполагает большое количество нюансов, разобраться с которыми не так-то просто. Как вариант, можно воспользоваться услугами специальных компаний-посредников, специализирующихся на написании абуз в ICANN.

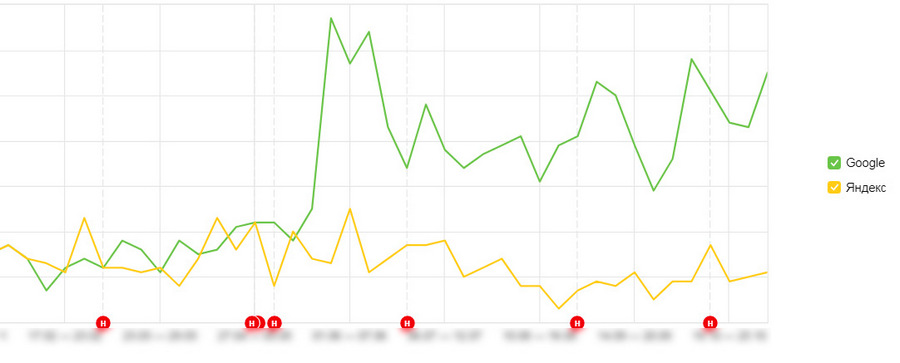

Решение контентных споров может затянуться надолго и с большой долей вероятности закончиться ничем. Это не лучший сценарий для тех, кто из-за копипастеров потерял позиции в выдаче и несет убытки. В таких случаях куда эффективнее — попробовать вернуть утраченные позиции. Для этого актуализируйте статью: допишите 1-2К знаков, обновите дату публикации и отправьте документ на переиндексацию. Дополнительно сделайте посев ссылками в соцсетях и поставьте 1-2 бэклинка на сторонних (тематически близких) сайтах. Актуализируя статью, следите за тем, чтобы новый текст не размывал релевантности старой семантики.

Это должно дать результат. Особенно хорошо такой финт работает в Google. Некоторые веб-мастера даже стараются держать под рукой запасной контент, чтобы максимально быстро реагировать на просевшие позиции в подобных ситуациях. Это особенно актуально в конкурентных нишах, где кража контента является очень распространенной практикой. Естественно, все это предполагает постоянный контроль позиций и автомониторинг страниц сайта на плагиат.