Рейтинг статьи: 3,80

На любом сайте время от времени возникает необходимость в удалении страниц. Если просто удалить документ в админке, он останется в поисковом индексе. По крайней мере, так будет продолжаться какое-то время. Чтобы полностью убрать страницы и их содержимое из результатов поиска Google и Яндекса используют другие подходы. Способов это сделать довольно много, но ни один из них не является универсальным.

Оптимальную схему удаления всегда выбирают по ситуации. В противном случае, можно не только оставить в поиске нежелательное содержимое, но и навредить SEO-оптимизации своего сайта. Далее мы разберем восемь самых рабочих способов удаления URL-адресов. Расскажем, в каких случаях уместно применять каждый из методов и как избежать распространенных ошибок, негативно влияющих на SEO.

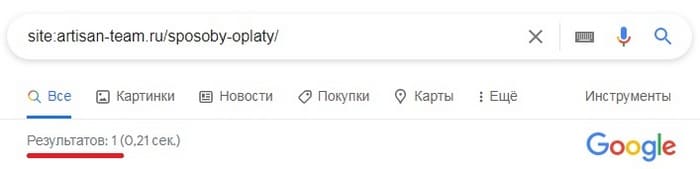

Прежде чем приступать к удалению страниц, логично убедиться, действительно ли они присутствуют в индексе. Во-первых, это нужно, поскольку и Google, и Яндекс могут игнорировать некоторые страницы (обычно с малозначительным содержимым); во-вторых, если мы говорим, например, о 404-х страницах, со временем они сами вылетают из индекса.

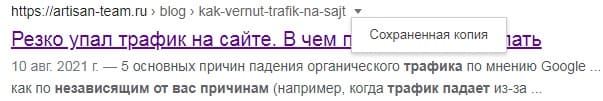

Обычно индексирование страниц проверяют через запрос с поисковым оператором site:

Если поисковик находит URL-адрес через оператор site:, вероятнее всего, документ проиндексирован (но бывают и исключения)

Этот способ, действительно, самый удобный. Он незаменим, например, для быстрого анализа конкурентов, когда нужно на глаз оценить масштаб их сайтов. Но для точеной проверки URL он не подходит, т. к. может в некоторых случаях предоставлять некорректные данные. Например, в результатах поиска может быть показан не запрашиваемый документ, а страница с редиректом, которой формально не существует.

Чтобы точно понять, есть URL в индексе или нет, лучше использовать консоли вебмастера Google и Яндекса.

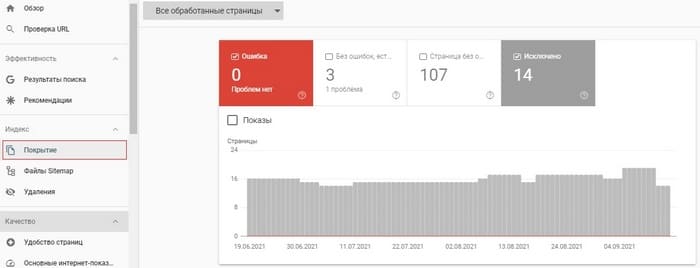

В Google Search Console вся актуальная информация, касающаяся индексирования страниц, доступна на вкладке Индекс → Покрытие:

Чтобы проверить страницу еще быстрее, просто вставьте нужный URL-адрес в строку поиска вверху консоли.

![]()

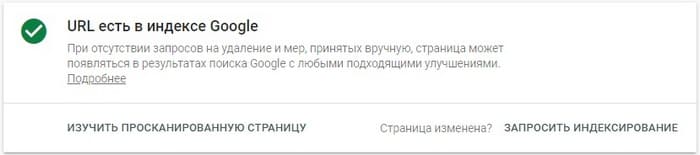

Если страница в индексе, будет доступно соответствующее уведомление:

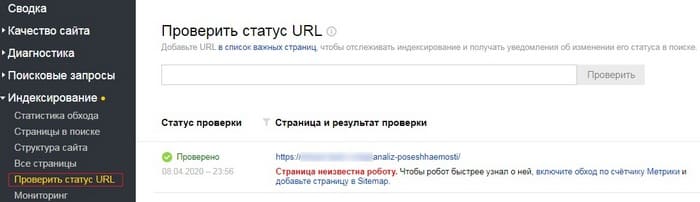

В Яндекс.Вебмастере (Индексирование → Проверить статус URL) для проверки индексирования также предусмотрен отдельный инструмент.

Вам ничто не мешает поступить самым очевидным способом – и просто удалить страницу вместе со всем ее содержимым в админке сайта. Это весьма топорный метод, но и его можно использовать, если быть в курсе некоторых нюансов.

После удаления документа этим способом необходимо проверить коды ответа сервера, и убедиться, что они отдают статус HTTP 404 (не найдено) или 410 (удалено). Хоть фактически страница и удалена, тем не менее она остается в индексе и продолжает ранжироваться, до момента пока поисковые роботы не совершат переобход сайта. В отдельных случаях это может занять довольно много времени. В дополнение к этому, даже несмотря на фактическое отсутствие документа, содержимое удаленной страницы будет оставаться доступным в кэше для всех желающих.

Также при удалении и деиндексировании страниц могут возникнуть проблемы с файлами, формат которых отличен от HTML, например, документами PDF, DOC, XLS и др. – их нужно удалять с сервера полностью.

Как мы видим, у этого способа есть немало нюансов, поэтому во многих случаях он не подходит. Его не нужно использовать в следующих ситуациях:

Когда необходимо удалить страницы в срочном порядке. Например, если это документы, сгенерированные вредоносным скриптом после взлома сайта. Ждать запрошенной переиндексации в этом случае – плохой вариант.

Когда на страницу стоят сильные обратные ссылки. Удаление документа в этом случае приведет к «сгоранию» сигналов, усиливающих SEO вашего сайта.

Когда нужно оставить страницу доступной для пользователей. Например, это может быть актуальным, если вы не хотите, чтобы в индексе ранжировались технические страницы с неуникальным контентом (пользовательское соглашение, политика конфиденциальности и пр.).

В этих и ряде других случаев используют менее топорные способы скрытия страниц из поиска.

Для Google

В Google есть отдельный инструмент для быстрой деактивации нежелательных URL. Но его название может вводить в заблуждение, поскольку он удаляет страницы из поиска не навсегда, а только на время. Это удобно, когда нужно действовать незамедлительно, например, после взлома сайта, но в дальнейшем нужно не забыть применить другой метод постоянного удаления.

Эффект от блокировки длится порядка шести месяцев. Все это время Google видит и обрабатывает отклоненные страницы, но не отображает их в выдаче. На обработку самого запроса на скрытие может уйти до суток, хотя на практике это происходит значительно быстрее. В отдельных случаях система может не выполнить запрос на удаление URL, поэтому после подачи заявки нужно отслеживать ее статус, и если она будет отклонена, вам сообщат по какой именно причине. Вместе с самой страницей также на время можно убрать из выдачи ее кэшированную версию.

Таким образом, инструмент для деактивации URL в Google целесообразно использовать только при форс-мажорах, когда нужно экстренно удалить документ:

Для удаленных URL-адресов, с кодом статуса 404, 502 или 503, запрос на блокировку не работает.

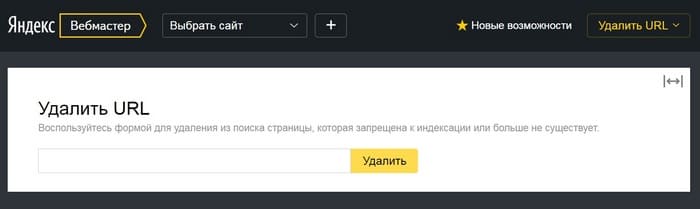

Инструмент для удаления в выдаче Яндекса

Запросить ускоренное удаление URL из выдачи Яндекса можно через соответствующий инструмент в Вебмастере. Но здесь есть важный нюанс: этот способ подходит только для деиндексирования документов, которые уже удалены либо закрыты для сканирования поисковыми роботами (через тег noindex или блокировку в robots.txt).

С помощью метатега robots в HTML-коде страницы вы можете указывать поисковым работам правила обработки для конкретных URL-адресов. Чтобы запретить к индексированию нужную страницу и исключить ее из результатов поиска, к метатегу robots добавляют параметр noindex. Саму запись размещают в элементе head и выглядит она так:

Запрещающую директиву noindex в метатеге robots (не путать с robots.txt) можно использовать в поиске Google, Яндекс и Bing.

Для каких случаев такой способ НЕ подходит:

Чтобы поисковые краулеры увидели и распознали метатеги с нужными директивами, страницы должны быть доступны для сканирования. Поэтому важно удостовериться, что они не закрыты от обхода в robots.txt.

Запрет на индексирование определенных URL также можно сделать через настройку HTTP-заголовка X-Robots-Tag на сервере. В этом случае используют уже упомянутую директиву noindex. HTTP-ответ, где заголовок запрещает индексирование документа, выглядит так:

Запрет через X-Robots-Tag принято считать более надежным способом деиндексирования, чем использование noindex в метатеге robots, поскольку вероятность, что поисковые краулеры проигнорируют директиву HTTP-заголовка значительно ниже. Также этот способ незаменим, когда URL-адрес, который нужно удалить из индекса, это не веб-страница, а, например, PDF-файл.

Тем не менее этот вариант не подходит, если нужно закрыть страницу, которая имеет хорошие обратные ссылки. Также данный способ неуместен, когда нужно деиндексировать страницу максимально оперативно.

Страницы с ограниченным доступом, например, защищенные паролем, по умолчанию закрыты для обхода поисковыми роботами и, соответственно, содержимое таких документов не попадает в индекс. Это довольно специфический способ управления индексированием, и актуален он лишь в тех случаях, когда нужно предоставить доступ к страницам только небольшому кругу пользователей. С технической точки зрения для ограничения доступа можно использовать одно из следующих решений:

В этих случаях поисковые роботы не смогут проиндексировать содержимое страниц, а сам контент не будет доступен сторонним пользователям. Это актуально при создании внутренних сетей, публикации платного или другого непубличного контента. Также доступ к страницам лучше ограничивать на этапах разработки или тестирования сайта, чтобы исключить индексирование технического «мусора». Если непубличный контент уже попал в индекс и его нужно срочно скрыть из кэша, используют метод №2.

Описанные выше способы касались удаления из индекса URL, по большей части не представляющих ценности для сайта. Теперь поговорим о ситуациях, когда нужно деиндексировать документы, которые полезны для продвижения и передают ценные SEO-сигналы. Обычно здесь имеют ввиду страницы с качественными обратными ссылками, которые по каким-то причинам нужно скрыть из индекса.

Деиндексирование URL с сохранением их ссылочного веса проводят одним из трех методов.

Редирект – это техническая настройка, которая автоматически перенаправляет с одного URL-адреса на другой. Их бывает несколько видов, но нас интересует главным образом редирект с кодом 301. Он не просто автоматически перенаправляет пользователей с неактуальной страницы (А) на нужную версию (В), но и указывает поисковым роботам, что весь ссылочный вес документа А нужно перераспределить на документ В, а саму исходную страницу удалить из индекса.

Важно понимать, что такие перенаправления работают только между тематически релевантными URL. Если вы решите сделать 301-редирект со страницы А, которая по содержанию не соотносится со страницей В, поисковикам сильно не понравятся такие манипуляции. Они не только блокируют перераспределение ссылочного веса, но и могут начать учитывать редирект как ложную ошибку (soft 404). Таким образом нужная версия страницы будет недоступной для пользователей.

Больше о принципах работы 301-редиректа и тонкостях его настройки – читайте в отдельной статье.

Добавление канонического тега rel=”canonical” – классическое решение проблемы дублей и один из способов управления индексированием. Если разные страницы на сайте имеют очень похожее содержимое или полностью повторяются – это серьезный недочет оптимизации. Поисковики умеют объединять такие дубли в группы. Из этого набора они выбирают самую информативную и релевантную страницу (ее называют канонической), а остальное удаляют из индекса. Но полагаться на работу алгоритмов не стоит, и лучше указать каноническую страницу самому – при помощи тега rel=”canonical”.

Технически в такой каноникализации нет ничего сложного: на всех второстепенных страницах нужно добавить фрагмент кода, который будет сообщать поисковикам, что это дубль, и указывать на основную (каноническую) страницу.

Например, у нас есть основная страница (www.example.com/blog) и ее дубль (www.example.com/blog_2). Чтобы подсказать поисковикам, какой документ главный, в HTML-код страницы /blog_2 нужно добавить такой фрагмент:

![]()

Атрибут rel=”canonical” поддерживается всеми поисковыми системами. При этом его нужно использовать, только когда страницы действительно дублируются или очень похожи по содержанию. Если поисковик посчитает, что это не так, атрибут rel=”canonical” будет проигнорирован, поскольку это рекомендация, а не обязательная директива. Также каноникалы имеют свойство слетать, поэтому их нужно время от времени проверять, особенно если на сайте проводили технические работы или вносили другие серьезные изменения.

Canonical не используют в связке с noindex (способ 3 и 4). Это конфликтующие сигналы для поисковиков, поскольку атрибут rel=”canonical” дает указание, что нужно проиндексировать другую страницу, а noindex рекомендует убрать документ из индекса. При использовании сразу двух атрибутов поисковые системы, вероятнее всего, учтут canonical, а noindex просто проигнорируют. Но возможен и обратный сценарий – тогда страницы не смогут передавать ссылочные сигналы, а это уже серьезный недочет внутренней оптимизации (по крайней мере, если таких страниц много).

Параметры — это часть URL, которая присоединяется обычно после знака ? в конце адреса. Необходимость в них чаще всего возникает, когда нужно отфильтровать страницу по каким-то характеристикам.

Например, у нас есть карточка женского платья со стандартным URL:

![]()

Если мы выберем другой цвет товара, исходная страница поменяет URL на такой:

А если мы найдем это же платье через фильтр магазина, URL карточки уже будет выглядеть так.

![]()

Во всех трех случаях мы имеем дело с одной и той же страницей, но разными URL. Чтобы помочь поисковикам корректно сканировать такие дубли, нужно задать настройки обработки параметров. В Google это делают с помощью инструмента «Параметры URL». Подробнее о принципах его использования – в официальной справке. Сам способ применяют исключительно для страниц с параметрами. Во всех остальных случаях применяют атрибут rel=”canonical” или другой из описанных выше методов каноникализации.

В Яндексе, насколько мы в курсе, подобного инструмента не предусмотрено. Чтобы исключить сканирование одинаковых страниц с параметрами, здесь используют другие схемы:

Когда нужно оперативно убрать изображение из поиска – удаляют всю страницу, используя способ №1. Это самая быстрая схема, которая к тому же позволяет сразу вычистить фото из кэша. Но инструмент удаления URL работает только под Google, поэтому картинки будут оставаться доступными в Яндексе. К тому же, если нужно убрать изображение из поиска, далеко не всегда целесообразно удалять всю страницу.

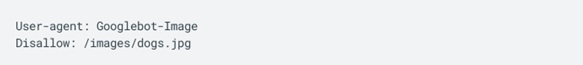

Более универсальный, хоть и не такой быстрый, способ скрыть картинки от Google и Яндекса – ограничить их сканирование в файле robots.txt, используя директиву Disallow (она запрещает индексирование разделов сайта, отдельных страниц или конкретного файла). При этом сами изображения будут оставаться на сайте. Это оптимальный вариант для тех, кто использует на своих страницах заимствованные фото и не хочет лишний раз засвечивать их в поиске.

изображение, расположенное по указанному адресу, будет закрыто от индексирования в Google

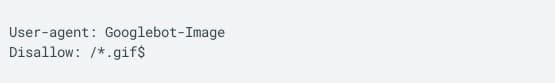

Этот способ более гибкий благодаря поддержке подстановочных знаков. В robots.txt можно запретить сканирование картинок определенного формата, например, только GIF-файлов:

Также здесь можно дать указание, отображать картинки в основном поиске, но блокировать их на вкладке с изображениями. Это позволит странице, например, отображаться в колдунщике с подтянутым фото на вкладке «Все результаты».

Директива Disallow поддерживается Google и Яндексом, но при необходимости можно заблокировать ранжирование изображений только в одной из поисковых систем. В то же время этот способ не такой быстрый, и чтобы фото пропали из результатов выдачи, придется дождаться переиндексирования.