Рейтинг статьи: 5,00

Имя Робби Ричардса имеет большой авторитет в мире SEO. Этот человек знает многое о современном поисковом продвижении, но что более важно — любит делиться своими знаниями с другими. В одной из статей Ричардс рассказывает о самых эффективных тактиках поискового продвижения1. Это своеобразная дорожная карта из 19 пунктов самостоятельной SEO-оптимизации, которая посильна в том числе для начинающих веб-мастеров.

Мы внимательно прочитали это большое руководство — что-то добавили от себя и кое-где подобрали аналоги инструментов — теперь пересказываем вам главное.

Первое с чего начинаем — это технический аудит. Здесь вовсе необязательно обкладываться чек-листами и неделями проверять показатель за показателем. Быстрый способ выявить все самые критичные проблемы на вашем сайте — использование специального софта. На сегодняшний день эти технологии шагнули вперед, и способны провести более качественный аудит, чем, например, начинающий оптимизатор. Буквально в один клик можно проверить состояние самых главных метрик и факторов, которые напрямую влияют на позиции в ПС.

Робби Ричардс предлагает делать это с помощью SEMrush (инструмент Site Audit), но вы можете использовать любые другие краулеры. Вот несколько примеров:

Выгружаем найденные ошибки и исправляем их — первый шаг сделан.

Эффект каннибализации возникает, если на сайте имеются похожие страницы: содержащие идентичные или очень близкие запросы. Это вводит в заблуждение поисковые системы, из-за чего начинаются проблемы с ранжированием. Более подробно о том, что такое каннибализация можно почитать в отдельной статье. По ссылке также доступен алгоритм автоматического сканирования сайта на предмет этой уязвимости.

Что делать с конкурирующими страницами:

— частично деоптимизировать менее релевантный документ;

— сделать 301 редирект с обеих страниц на новый документ;

— поставить 301 редирект с одной на другую;

— удалить менее качественную страницу.

Каждый из способов актуален для своей конкретной ситуации. Больше об этом — также по ссылке.

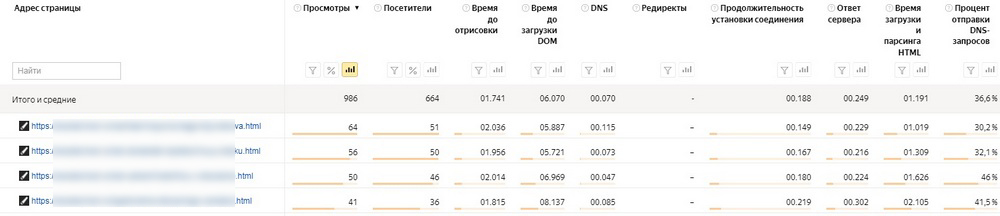

Скорость загрузки страниц — важный фактор ранжирования, который уже ни для кого не является секретом. Медленная скорость бьет по качеству пользовательского опыта, поведенческим, конверсиям — и это следует исправлять. Автор руководства советует сканировать сайт с помощью SEMrush, но для этих целей можно использовать множество других более доступных и не менее точных инструментов.

Начнем с того, что для мониторинга собственных сайтов хватает возможностей Яндекс.Метрики.

Отчеты → Стандартные отчеты → Мониторинг → Время загрузки страниц

Это отчет позволяет узнать среднее время загрузки сайта или нужной страницы с довольно подробной сегментацией данных. Также здесь можно отдельно проверить скорость загрузки Турбо-страниц и определить параметры отрисовки в разных регионах мира. Из недостатков: данные нужно интерпретировать самому и конкурентов вы уже не проверите.

Альтернативой могут стать такие сервисы как GTmetrix (его тоже рекомендует Робби Ричардс), PageSpeed Insights и др. Если вы тестируете сайты из России, лучше пользоваться локальными инструментами, чтобы нивелировать поправку на гео-фактор, например, это может быть sitespeed.ru, loading.express и пр.

В этом вопросе автор рекомендует минимальный пул работ по оптимизации.

Протестируйте свой хостинг. Если проблема в нем, меняйте тариф на более прокачанный или переезжайте к другому провайдеру. Как тестить текущие параметры хостинга и в целом выбирать надежных провайдеров — читайте здесь.

Проверьте размер изображений. Когда на сайте много больших картинок, определитесь, нужны ли они. Например, если это детализированная карта или инфографика с текстом, тогда гигантские расширения оправданы. Но если это рядовая картинка, например, 6000x2500px — это очевидный перебор. Такие фото нужно пережимать. В противном случае, их критическая масса будет замедлять скорость загрузки страницы, не принося никакой пользы.

Компрессия файлов без потери качества. Изображения пережаты до приемлемых расширений. Теперь не лишним будет компрессировать их при помощи специальных сервисов: TinyPNG, ShortPixel, Сompressor.io или Kraken. Некоторые из них творят чудеса: минимизируют вес файла до 70% без визуально заметных потерь качества.

Проверьте настройки кеширования. Для сайтов на WordPress эту проблему можно решить при помощи плагинов W3 Total Cache или WP Rocket. Они хранят статические элементы страниц в браузерах пользователей и при повторном посещении сайта, загружают часть данных локально, что ощутимо повышает скорость отрисовки.

Внедрите «ленивую загрузку». Механизм отложенной загрузки оптимизирует отрисовку длинных страниц, содержащих много изображений ниже первого экрана. Они загружаются либо по мере скролла, либо после рендеринга основного контента на странице. Для внедрения этой опции на WordPress-сайтах удобно использовать плагин A3 Lazy Load.

Еще больше советов, как разогнать свой сайт до небывалых скоростей — читайте в нашем материале.

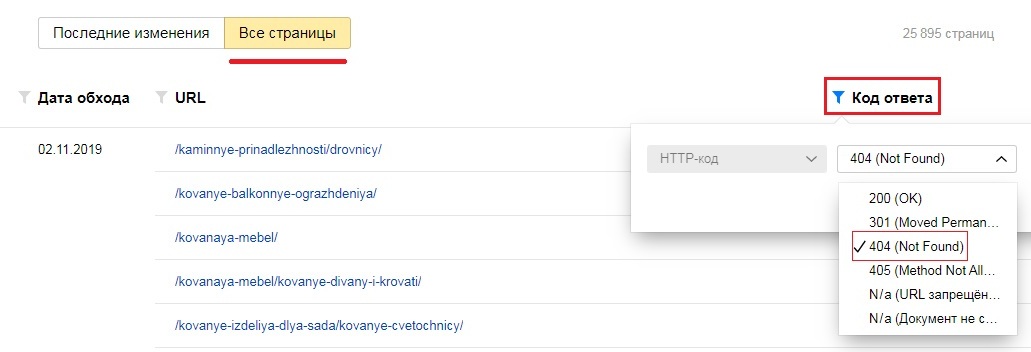

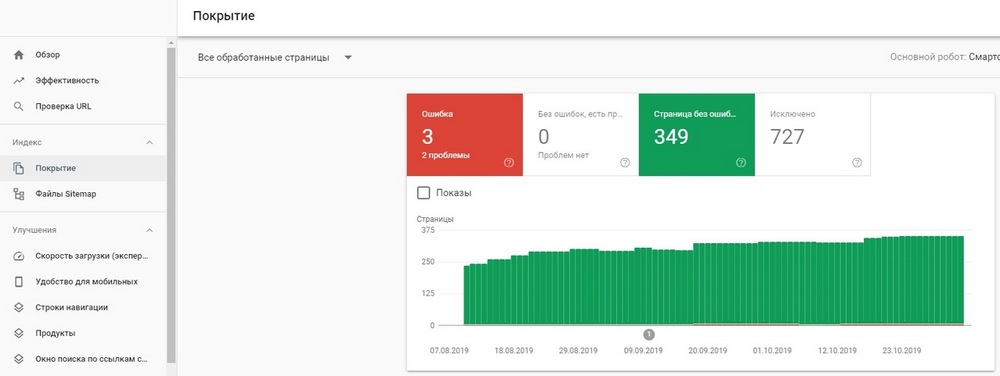

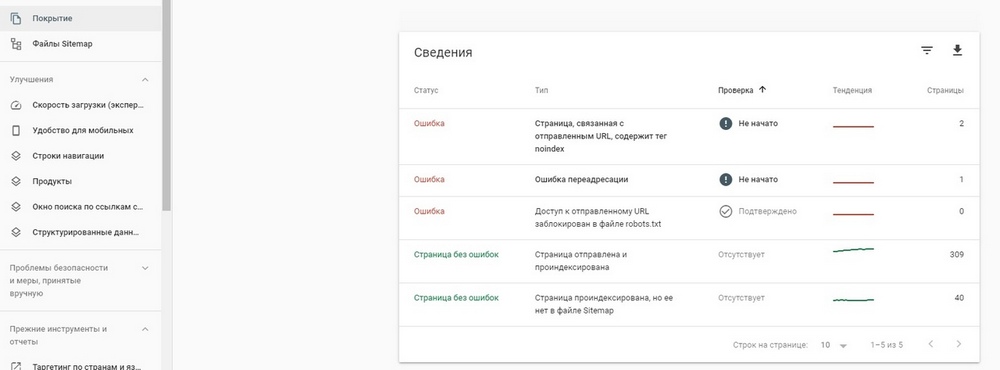

Некоторые страницы принято закрывать от индексирования. Это распространенная практика, но если по какой-либо причине для обхода заблокированы важные страницы — это уже серьезная проблема. Робби Ричардс рекомендует обязательно проверить этот момент.

Ошибки обхода остаются незамеченными очень часто. Например, настройки индексирования могут слететь после серьезных технических работ на сайте: редизайна, изменения структуры, переезда на новую CMS. Веб-мастер может допустить банальную оплошность: закрыть от роботов не то, что нужно или забыть восстановить обход, который ограничивал на время технических работ.

Для сканирования автор руководства рекомендует использовать все тот же SEMrush. Он действительно очень удобный для этих целей: точно локализует проблему, дает развернутые отчеты и рекомендации по устранению недочетов. Но находить ошибки обхода умеет и большинство других краулеров.

Больше о настройках индексирования и способах закрытия страниц — читайте в отдельном материале.

Здесь все понятно: неработающие ссылки не нравятся пользователям и поисковым системам. Есть небезосновательное мнение, что критическая масса битых линков ухудшает поисковый рейтинг сайта, и уж точно они не идут на пользу поведенческим факторам. Добавим сюда неэффективный расход краулингового бюджета, и становится очевидным — проблему нужно решать.

Штатными инструментами веб-мастера:

Яндекс.Вебмастер

Google Search Console

Сторонними сервисами: Xenu Link Sleuth,Online Broken Link Checker и др.

Больше о битых ссылках и о том, что с ними делать — читайте в этой статье.

Страницы с расширенным содержанием обычно занимают более высокие позиции в выдаче, чем те, которые имеют меньшее количество слов и раскрывают тему по верхам. Особенно четко эта закономерность прослеживается в Google. Найти такие страницы можно при помощи SEMrush (отчет Site Audit Overview, раздел Warnings section) или другого софта, например SerpStat.

Первым делом — выгрузить список и посмотреть каждый URL вручную. Если страница объективно слабая, по ситуации, использую один из следующих сценариев:

— дописать и улучшить качество контента;

— удалить страницу, если она не генерирует трафик, конверсии и не имеет внешних ссылок.

— добавить 301 редирект на новую более качественную страницу замены, если старая каким-то необъяснимым образом смогла получить нормальные обратные ссылки (так вы сохраните капитал бэклинков).

Дублированный контент — это две или более страницы, чье содержимое идентично на 85% и более. Полные или неполные дубли появляются как из-за технических ошибок, например, неправильных настроек URL, так и по причине человеческого фактора. Как и в случае с каннибализацией (см. пункт 2), поисковые системы плохо понимают, какие страницы отображать в индексе, из-за чего начинаются проблемы.

Проще всего это сделать при помощи Яндекс.Вебмастера.

Индексирование → Страницы в поиске

![]()

Переходим на вкладку «Все страницы», и выгружаем список всех страниц сайта в предпочитаемом формате. Открываем файл. Дубли будут иметь статус DUPLICATE.

Проверить сайт на наличие дублей можно при помощи любого другого более или менее серьезного краулера для SEO-аудита.

— добавить на дублях rel=canonical, чтобы указать ПС какую страницу вы хотите видеть в результатах поиска;

— сделать 301-й редирект на основную страницу (если дубли успели собрать обратные ссылки);

— уникализировать содержимое каждого документа;

— удалить, если страницы не несут ценности для пользователей и не имеют ссылок.

Здесь речь идет о том, чтобы найти страницы, которые после небольшой оптимизации смогут качественно усилить свои позиции. Механика этого процесса показана Робби Ричардсом на примере SEMRush.

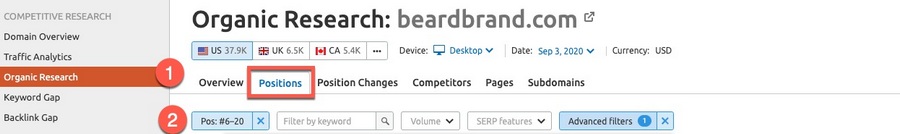

1. Задаем нужный домен и делаем выгрузку из анализатора позиций (Organic Research → Positions).

2. Устанавливаем диапазон запросов: берем на проработку те, у которых позиция с 6 по 20.

3. Выгружаем результаты в виде CSV-файла.

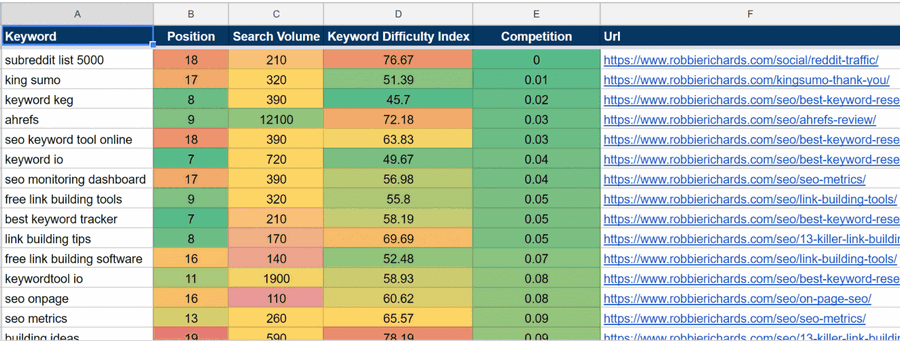

Далее экспортируем данные в этот шаблон анализа ключевых слов.

— переходим на лист 1. SEMRush KW Opp;

— копируем данные из выгруженного CSV-файла и вставляем их в лист 1. SEMRush KW Opp;

— перейдя во вкладку DONE в ней должна быть таблица, похожая на эту.

Зеленые ячейки — наиболее перспективные запросы, то есть ключи, которые интересуют потенциальных пользователей и при этом имеют низкий уровень конкуренции. Чтобы заставить их приносить максимум пользы сайту, необходимо улучшить качество контента. Для этого:

— улучшаем качество текстов, их оформление и форматирование;

— добавляем подтемы в статье под НЧ семантику;

— ставим на каждый материал по 3-5 ссылок с трастовых и тематически релевантных сайтов;

— расшариваем материал в соцсетях;

— обязательно обновляем дату публикации и отправляем страницу на переробход в вебмастерках.

Ждем какое-то время. Обычно позиции улучшаются через 2-3 недели.

Здесь делаем тоже самое, что и в предыдущем пункте, только вместо своего сайта снимаем позиции (с 6 по 20) у двух-трех самых топовых конкурентов.

Думаем, здесь все понятно. Единственное что стоит сказать: спарсить эту информацию при помощи бесплатных инструментов вряд ли получится. Для этого придется приобретать подписку на серьезные анализаторы: SEMRush, Ahrefs, Spywords или другие.

В то же время, приобретя подписку в самой упрощенной версии, вы получите доступ к такому объему стратегически важной информации, которую сможете использовать еще очень долго. Помимо автоматической выгрузки самих конкурентов и списка их трафиковых страниц, вы увидите перечень ключевых слов, по которым ранжируется каждая страница или, например, как оформлены метатеги к каждой статье. В общем, для тех, кто планирует серьезно подходить к оптимизации своего сайта, инвестирование в инструменты имеет смысл.

Конечно, спарсить топовые страницы конкурентов — это только половина дела. Самое сложное впереди, и заключается в том, чтобы подготовить более качественный контент.

Определите упущенную семантику — запросы, по которым у конкурентов есть позиции, а у вашего сайта нет. В SEMRush — это смотрят через инструмент Keyword Gap. В Ahrefs — Content Gap. Также это можно сделать другим софтом: Spywords, Serpstat и пр. Бесплатно такую опцию предлагает be1 (в разделе «Расширение семантического ядра»). По крайней мере на момент написания этой статьи он выгрузил нам больше 400 упущенных запросов (весьма толковых) по десяти конкурентам.

Собрав такие ключи, выбираем самые перспективные и релевантные, после чего подготавливаем под них качественный контент.

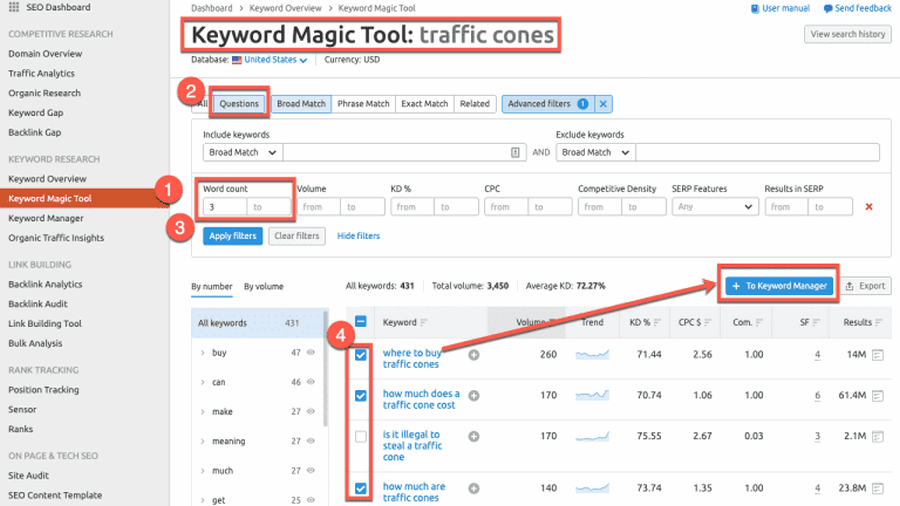

Вы собрали у конкурентов массив запросов. Теперь можно получить еще больше пользы от этой информации. Найдите запросы с длинным хвостом и сделайте под них контент. Как правило, это будут ключи, сформулированные в форме вопросов. В SEMRush для этих целей есть мощный инструмент Keyword Magic Tool. Он парсит упущенные ключевые слова в форме вопросов. Эта опция открывает большие возможности для работы с НЧ запросами. Отдельно отметим, что низкочастотники были важны всегда, но в эпоху голосового поиска их роль стала первоочередной.

Контент под запросы с длинным хвостом лучше всего подготавливаться в формате FAQ. Как это грамотно сделать — читайте здесь.

Сразу оговоримся, что не существует 100% точной формулы попадания на нулевую позицию. Совершенно не факт, что у вас это получится, но попытаться можно. В любом случае, даже если ничего не выйдет, внедренная оптимизация пойдет на пользу вашему SEO в других аспектах.

Как попасть в блок с быстрыми ответами Google:

1. Смотрим, по каким запросам на нулевую позицию попадают ваши конкуренты. Отдельной опцией это доступно в SEMRush или Serpstat. Делаем контент под аналогичные запросы, придерживаясь похожего объема и форматирования.

Можно пойти другим путем, придумать самому long tail запрос и посмотреть, есть ли по нему быстрые ответы. Обычно такие запросы начинаются с: как, что, когда, почему и т.д. Это можно сделать, например, в том же Serpstat или попробивать запросы вручную и посмотреть, выдает ли Google по ним нулевую позицию или нет.

2. Отвечайте в материале сразу на несколько связанных вопросов. Аналитики из Ahrefs выявили закономерность: если статья получает расширенный сниппет по конкретному запросу, то, вероятнее всего, в блок с ответами будут залетать и другие запросы с этой страницы.

3. Пишите коротко и лаконично. Используйте разбивку на абзацы, форматирование, заголовки H2.

4. Придерживайтесь оптимальной длины текста под каждый long tail запрос — 40-50 слов.

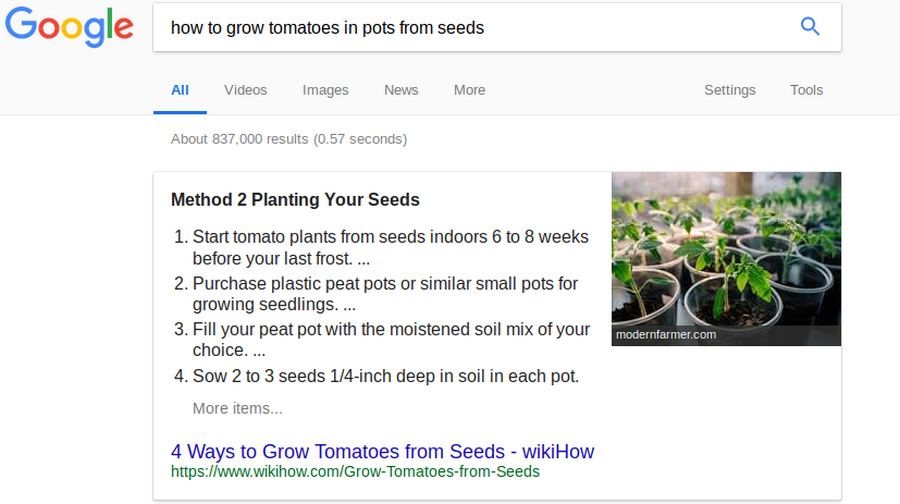

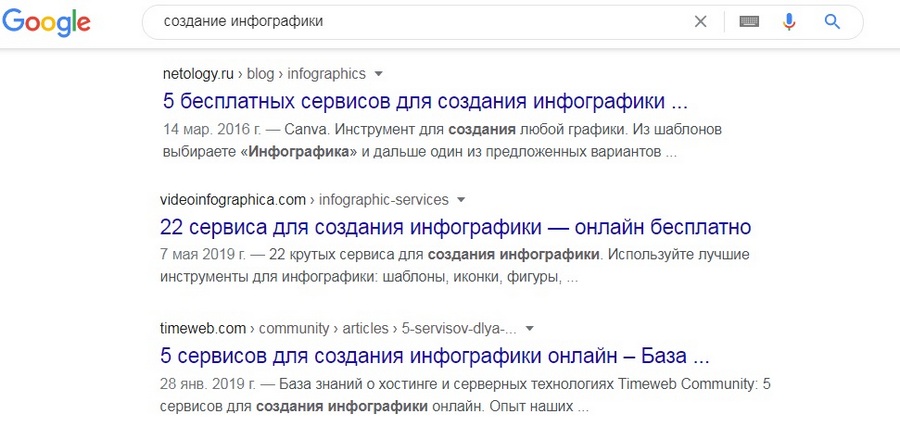

Если вы хотите, чтобы ваш контент занимал топовые позиции в выдаче, то он должен соответствовать интенту пользователя, т.е. отвечать его целям поиска. При подборе релевантных результатов — сайтов, которые наилучшим образом отвечают на вопрос — поисковые системы учитывают тип и формат контента. Поэтому при создании новых материалов или оптимизации старых важно проверять интенты запросов. Делается это просто. Пробиваем запрос в выдаче, и если в результатах преимущественно статьи — подготавливаем статью. Если в топе преобладают списки и подборки — делаем такой же листинг.

В топе выдачи по запросу «создание инфографики» преобладает контент в виде листингов. Очевидно, что у такого типа материалов больше шансов залететь в топ

Контент должен быть оптимизирован для поисковиков, но не меньшую ценность представлять и для живых пользователей. Совет — дельный, вечно актуальный и всем давно известный. Для простого и эффективного решения этой задачи Робби Ричардс предлагает инструмент SEO Writing Assistant, который доступен в виде расширения для Google Документов и WP-плагина. Он оценивает текст сразу по нескольким направлениям: легкость восприятия, уникальность, соответствие контента характеру и стилю бренда, SEO-оптимизация (ключевые слова, битые ссылки, переспам и т.д.). Если честно, мы не знаем, как он работает с русскоязычными текстами. Подобных аналогов среди русскоязычных инструментов — тоже не встречали. Обычно эти задачи решают набором разных сервисов. Больше о них — здесь.

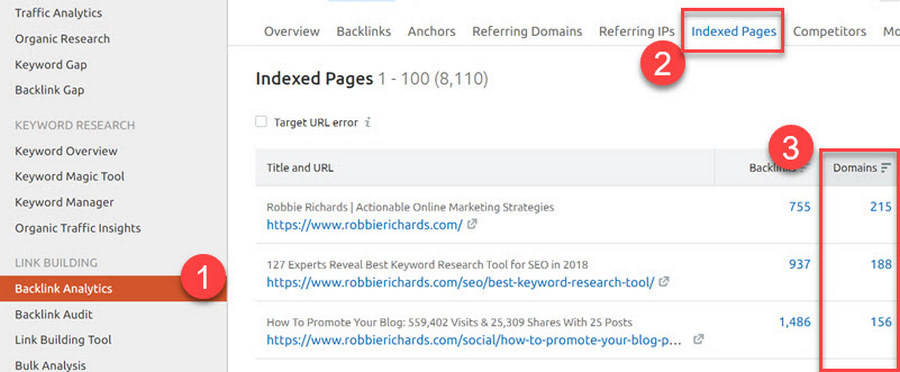

Здесь речь идет о грамотной внутренней перелинковке. Она должна быть одной из первых мер оптимизации, которые предпринимают для продвижения недавно опубликованного или обновленного контента. Суть эффективной перелинковки проста: проставить релевантные ссылки на материал с других наиболее трастовых страниц сайта. Так контент со старта получит мощный импульс для продвижения.

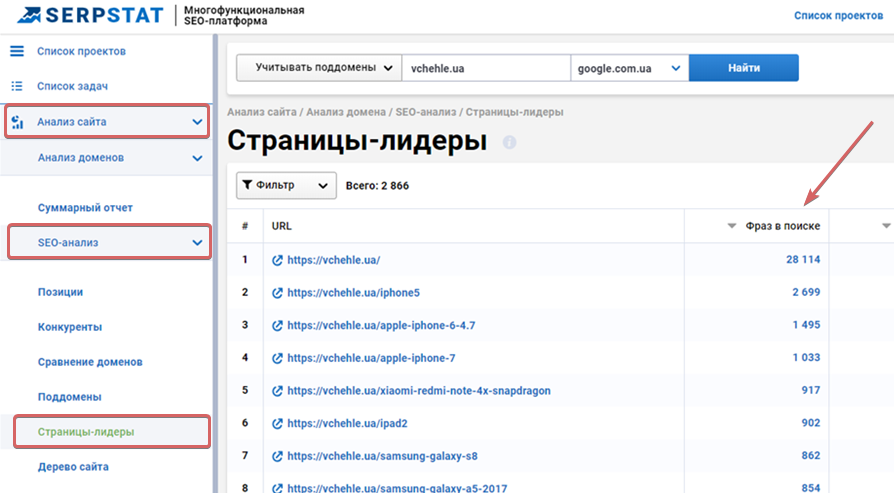

Как узнать такие страницы? Обычно их список можно выгрузить через любой мало-мальски серьезный анализатор. Автор руководства использует SEMRush. Он смотрит страницы с наибольшим количеством обратных ссылок, которые в большинстве случаев и являются наиболее авторитетными на сайте.

Ричард рекомендует добавлять одну внутреннюю ссылку с любой из этих страниц, даже если тематики материалов не на 100% соответствуют друг другу.

Посмотреть сильные страницы сайта также можно через данные метрики, например, используя отчет «Страницы входа» в Яндекс.Метрике.

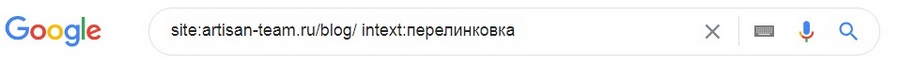

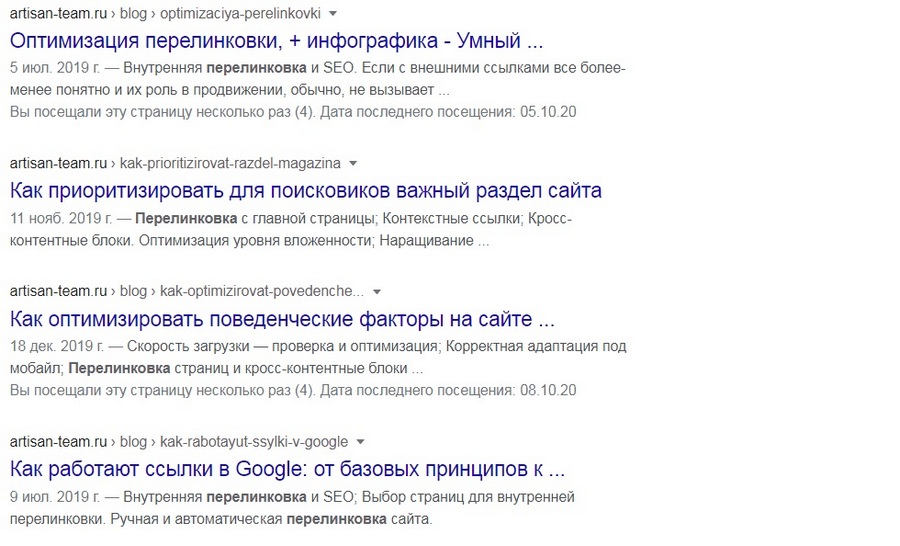

Для поиска дополнительных источников, в которых можно проставить ссылки на новую статью, используйте операторы расширенного поиска. Например, мы написали статью про перелинковку и хотим проставить в ней релевантных ссылок из других публикаций. Для этого:

1. Используем оператор site: + название сайта artisan-team.ru/blog/ (обратите внимание, мы сразу ограничили директорию поиска одним только блогом)

2. Добавляем второй оператор intext: (он ограничивает результаты выдачи конкретными словами) и указываем интересующий нас запрос: «перелинковка».

Таким образом, мы имеем следующую поисковую конструкцию

3. Результаты выдачи по такому запросу будут ограничены только статьями, в той или иной мере связаными с перелинковкой. Из них удобно выбирать подходящий вариант для проставления ссылки.

Мы не смогли подобрать корректный аналог данному термину, поэтому объясним более развернуто. Существуют тематики, в которых получить позиции на первой странице выдачи — просто нереально. Например, если вы продвигаете отельный бизнес, смиритесь с тем, что топ будет плотно занят агрегаторами и другими ресурсами, с которыми невозможно конкурировать по трасту. Это же касается сайтов, в продвижение которых инвестируют многозначные суммы, и состязаться с ними за высокие позиции малому и среднему бизнесу — бессмысленно. Один из немногих способов занять свое место под солнцем — тактика Barnacle SEO.

Этот термин был придуман Уиллом Скоттом и прочно закрепился в кругу западных сеошников. Barnacle — это небольшие морские рачки, известные тем, что прикрепляются быстро плавающим животным. Используя эту аналогию, Скотт предложил рядовым сайтам задействовать возможности больших открытых площадок и продвигаться через их траст. Речь идет о нишевых каталогах, обзорных сайтах, тематических агрегаторах, сервисах с ответами на вопросы и т.д.

Таким образом, имеет смысл посмотреть, какие страницы мощных сайтов отображаются в поиске по нужным вам запросам и попробовать поставить на них хорошую ссылку с информацией о себе. Например, если вы продвигаете страницу по информационному запросу, качественный бэклинк можно получить на сайтах-вопросниках: Яндекс.Кью, quora.com, ответы Mail.ru. По коммерческим запросам хорошо работают агрегаторы, отраслевые каталоги, доски объявлений, справочники.

Найдите все неактивные упоминания вашего сайта/бренда и попросите владельцев сайтов поставить активную ссылку. Механику такого мониторинга автор показывает на примере семрашевского инструмента Brand Monitoring. В нем же можно настроить уведомления. Поскольку сообщений придется рассылать много, целесообразно подготовить текстовый шаблон, который вы будете отправлять каждый раз, когда будет появляться неактивное упоминания вашего имени.

Проставление обратных ссылок на тех же площадках, которые используют конкуренты — наиболее эффективная стратегия линкбилдинга.

Лучшие инструменты для этих целей: Backlink gap в SEMRush или Link Intersect в Ahrefs.

На что обращать внимание:

каких доноров используют конкуренты;

какие виды контента и темы получают больше всего обратных ссылок;

с каких доменов конкуренты получают ссылки, а вы нет;

соотношение анкорных и безанкорных бэклинков.

Вы также можете посмотреть, как топовые сайты формирую свой ссылочный капитал. Используют ли они гостевой постинг, покупают ссылки в материалах сайта или на них ссылаются естественным образом.

Теперь у вас есть 19 мощных советов по улучшению собственного SEO, которые посильно реализовать самому или с небольшой командой. Все описанное выше, естественно, не делается за один-два дня. На внедрение этого пула работ может уйти не один месяц, но результатом этих усилий станет мощный импульс для сайта на последующие несколько лет.