Рейтинг статьи: 5,00

Падение поискового трафика происходит по разным причинам. Характер просадок также отличается: он может быть кратковременным, с последующим частичным или полным восстановлением, или резким, без дальнейшей положительной динамики. Но даже самые сильные проседания – это обратимый процесс и их можно исправить. Нужно только выявить причину, что зачастую бывает непросто. Как понять, что именно произошло с сайтом, устранить недоработки и восстановить показатели посещаемости – об этом рассказали1 представители Google. Мы пересказываем их рекомендации и делимся своими наблюдениями на эту тему. Речь будет идти только о внутренних проблемах, возникающих на стороне сайта.

5 основных причин падения органического трафика по мнению Google

Существует пять распространенных причин проседания трафика из поиска. Каждой присуща своя динамика, которую можно легко проследить на графиках в Search Console, Google Аналитике или Яндекс.Метрике. Ниже на картинке можно увидеть, как, по мнению Google, выглядит динамика просадки в каждом из пяти случаев.

Просадки посещаемости часто связаны с ошибками, которые мешают краулерам Google и Яндекса сканировать сайт или отдельные страницы. Это может происходить как по независящим от вас причинам (например, когда трафик падает из-за недоступности сервера или других проблем на стороне хостера), так и из-за внутренних ошибок на сайте. Сами же ошибки индексирования могут быть на уровне хоста или отдельных страниц (например, если индексирование блокируется метатегом noindex в HTML-коде страницы). Далее мы будем говорить именно о внутренних ошибках и недочетах.

Чаще всего ухудшение ранжирования объясняется косяками самих веб-мастеров. Обычно это случается после глобальных технических изменений, таких как переезд сайта на новую CMS, редизайн, передел структуры, массовый перенос статей в другие рубрики, актуализация большого объема контента и т. д. Подобного рода апгрейды часто по умолчанию вызывают временные колебания позиций и незначительные просадки трафика (обычно потом все восстанавливается). Но все может значительно усугубиться, если после/во время работ вебмастера что-то недоглядели, не знали или забыли настроить.

– Статус HTTP: где 200-е коды изменились на 404-е.

– Редиректы: появились ли новые и учтены ли старые.

– Проверка rel=«canonical»: где изменился этот атрибут и корректно ли он прописан.

– Robots.txt: проверяем запрещающие директивы для роботов Google и Яндекса (эти ограничения полностью не заблокируют индексирование, но создадут определенные сложности, например, снизят скорость сканирования).

– Страницы в индексе: сравниваем количество страниц до и после внесения изменений на сайте.

Совет!

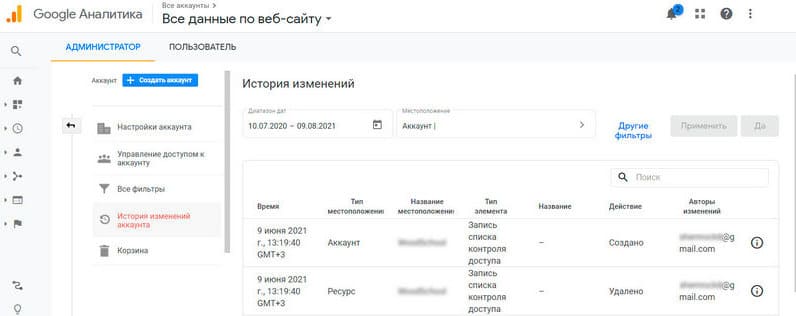

Чтобы определить причину просадки трафика, проверьте историю изменений в Google Analytics. Это позволит увидеть, какие технические изменения предшествовали спаду посещаемости.

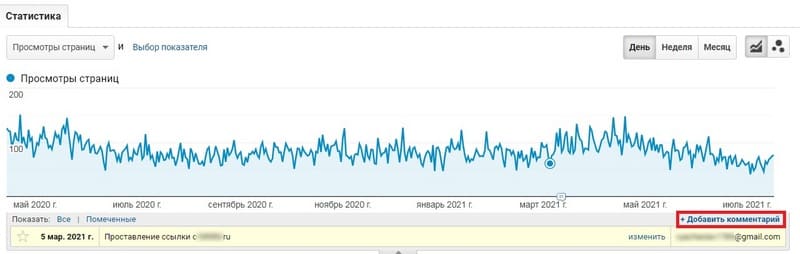

Администратор → История изменений ресурса

А также советуем завести привычку, оставлять метки и комментарии в GA или Яндекс.Метрике при внесении каких-либо значимых изменений на сайте, будь то технические правки, актуализация старого контента, публикация перспективного материала и т. д. Благодаря таким аннотациям, на графике можно будет увидеть, какие действия предшествовали падению или росту трафика на сайте.

Внутренняя перелинковка стала менее значимым SEO-фактором, и поисковики теперь отдают приоритет другой группе SEO-сигналов. Тем не менее, если мы говорим о связях между самыми важными страницами сайта, например, главной или страницами второго уровня вложенности, здесь перераспределение ссылочного веса по-прежнему может сильно влиять на ранжирование. Вместе с тем взаимосвязь внутренних ссылок легко нарушить, когда меняют структуру сайта или выполняют другие действия, связанные с изменением URL. В этом случае страницы могут ослабить позиции и потерять в трафике. Поэтому после любых серьезных изменений нужно проводить сканирование сайта на предмет битых ссылок, не дожидаясь, когда об этом придет уведомление в вебмастерках.

Вместо того чтобы тратить ресурсы на написание статей с нуля, многие вебмастера предпочитают дорабатывать или переписывать старые материалы, которые отлежались в поиске и накопили определенный траст. Это довольно популярная стратегия оптимизации, способная давать неплохой прирост трафика. Но есть нюанс: нет никаких гарантий, что вы не сделаете хуже, чем было. Поэтому ни один опытный оптимизатор без острой надобности не будет трогать контент, который более или менее нормально отрабатывает в поисковой выдаче.

«Мертвые» статьи, не приносящие никакого или совсем небольшой трафик, – тоже плохие кандидаты для актуализации. Их нулевая эффективность может объясняться не низким качеством или неудачной оптимизацией, а тем, что поисковые алгоритмы не считают сайт релевантным теме пользовательского запроса. В таких ситуациях актуализация окажется, вероятнее всего, бесполезной.

Лучшие кандидаты для перезапуска – это статьи, которые когда-то давали много трафика, но из-за опустившихся позиций в поиске ухудшили свои показатели.

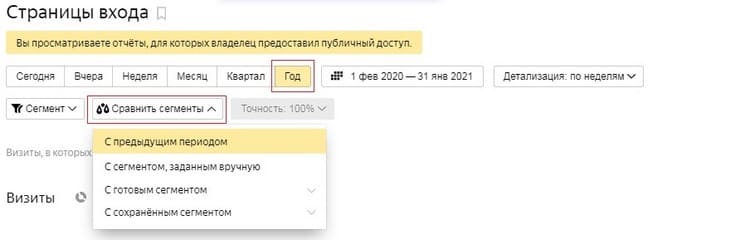

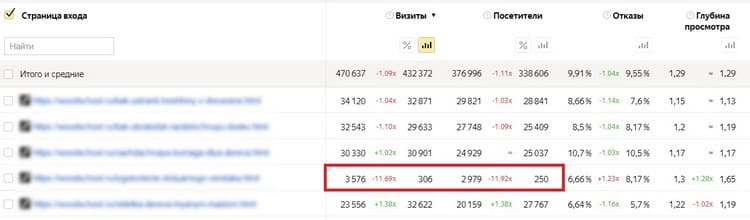

Отчет «Страницы входа» → Берем данные за относительно большой период Сравниваем сегменты:

Оцениванием разницу по визитам:

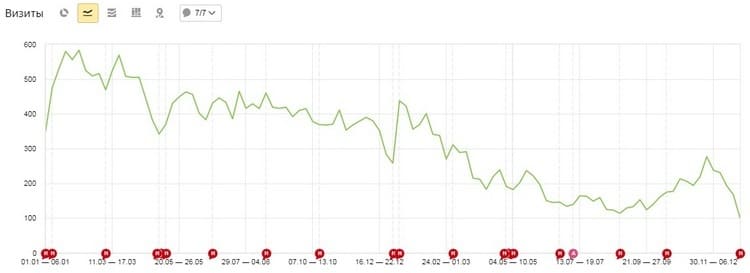

Смотрим график по каждой просевшей странице и решаем – актуализировать или нет

✓ Оптимизаторы ограничиваются только дополнительными ключами, вместо дописывания/переписывания текста.

✓ Переписывают TDH, но не вносят изменений в сам текст (тайтлы и H-заголовки лучше не трогать вовсе).

✓ Актуализируют статью под слишком широкий или нетематический кластер ключей, которые противоречит изначальным интентам статейных запросов.

✓ Вносят изменения в URL-адрес. Это, пожалуй, самая грубая ошибка. Изменив даже один символ в URL, поисковики станут воспринимать статью не как обновленную, а как новый документ с неуникальным контентом.

✓ Не обновляют дату перепубликации.

✓ Забывают отправить актуализированную статью на переобход в вебмастерках ПС.

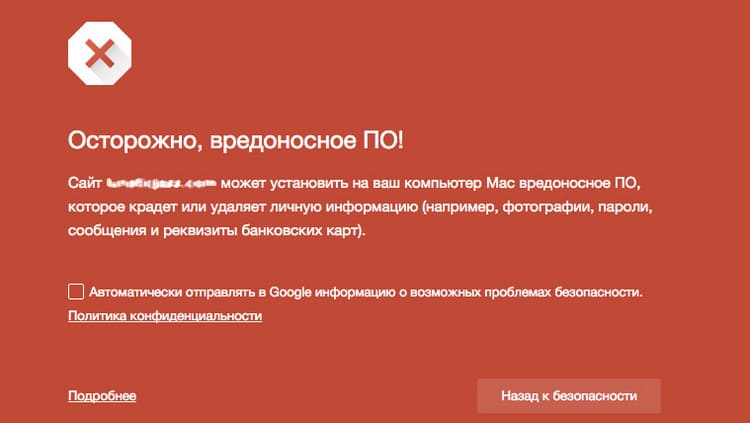

Сайт, на которых Google обнаружил проблемы безопасности, отмечается в выдаче как небезопасный. При попытке перехода, поисковик предупреждает пользователя, какие потенциальные риски влечет посещение страницы. Естественно, такие предупреждения отталкивают большую часть аудитории – из-за этого резко падает трафик. Аналогичным образом обстоят дела и в Яндексе.

Сайт заражен или на нем присутствует вредоносное ПО. Как правило, такие проблемы – следствие взлома.

Наличие в коде сайта вредоносных скриптов. Обычно это следствие взлома или установки сомнительных плагинов. Вредоносный код может перенаправлять посетителей на другой сайт или, например, майнить криптовалюту в их браузерах.

Ссылочные инъекции. Разновидность взлома, при котором злоумышленники добавляют на страницы скрытый ссылочный спам.

Создание вредоносных URL. Тип взлома, при котором злоумышленники генерируют на сайте отдельные страницы, наполняя их запрещенным контентом или используя их для нежелательных действий, например, редиректа или DoS-атак.

Фишинг. Содержимое сайта заставляет пользователей делать потенциально опасные действия, цель которых – получение доступа к конфиденциальной информации (логинам, паролям, данным банковских карт и пр.).

Скачивание вредоносного/нежелательного ПО. На сайте предлагают скачать ПО (напрямую или через ссылку), которое, по мнению ПС, имеет сомнительную репутацию.

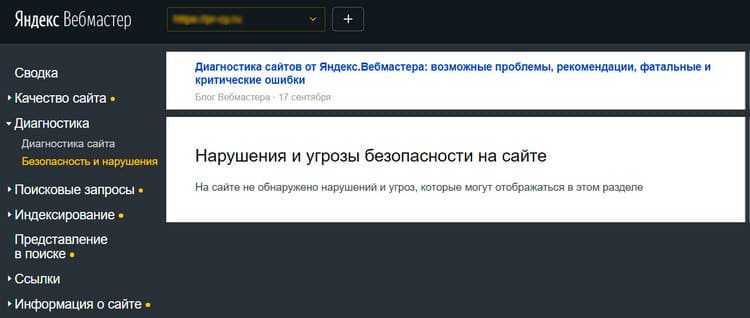

Если Google определит, что для вашего сайта актуальна одна из описанных ситуаций, информация об этом отобразится в отчете «Проблемы безопасности» в Search Console. В Яндекс.Вебмастере такое уведомление появится в разделе Диагностика → Безопасность и нарушения. Таким образом, при резкой просадке трафика, первое что делают – проверяют соответствующие разделы вебмастерок на предмет уведомлений. Здесь будет доступно описание проблемы безопасности и, если актуально, список URL, на которых она присутствует.

Несмотря на ежедневное сканирование сайта на предмет взломов и заражений, это не гарантирует того, что поисковики своевременно распознают и оповестят об угрозе. Таким образом, если есть подозрения на взлом, необходимо действовать самостоятельно, и проанализировать изменения на стороне хостинга, запросив логи веб-сервера. Далее проверяют:

В качестве мер первой необходимости нужно сменить пароли от хостинга, ftp и админки. Далее просканируйте сайт антивирусом или обратитесь за помощью к хостинг-провайдеру. Дополнительно можно написать «платонам» Яндекса, что на сайте был взлом и вы провели работы по устранению его последствий.

Когда владельцы сайтов нарушают рекомендации по обеспечению качества ресурса, Google и Яндекс могут в частном порядке наложить ручные санкции. В результате таких мер весь сайт или отдельные страницы будут исключены из поиска. Соответственно, трафик из Google/Яндекса упадет полностью или просядет только частично.

Чаще всего такие санкции прилетают тем, кто перестарался в SEO-оптимизации или преднамеренно использовал серые методы продвижения. Есть еще варианты откровенно черного SEO (клоакинг, автоматически сгенерированный контент, скрытые редиректы, дорвеи), но такие манипуляции с выдачей мы оставим за скобками нашего разговора.

Подобного рода попытки обмануть поисковые системы быстро заканчиваются наложением ручных санкций.

Намного чаще причиной выпадения из индекса являются не грубые SEO-манипуляции, а излишне активная работа по продвижению сайта. К таким огрехам переоптимизации обычно относят:

Политика по обеспечению качества ресурсов в Google и в Яндексе почти идентична. Поэтому сайты, использующие серые методов продвижения, со временем остаются без органического трафика из обеих поисковых систем.

О ручных штрафах приходят уведомления в консоли вебмастера. Поэтому при явных просадках трафика из Google нужно перейти в Search Console и проверить вкладку «Меры, принятые вручную». Если причина пессимизации в ручных санкциях, в вебмастерке будет уведомление с описанием нарушения и перечнем URL, на которых они присутствуют. Если проблемы на сайте носят комплексный характер и не связаны с конкретными документами — обычно это последствия накруток, автогена страниц, прогона сайта по мусорным каталогам и т. д. — URL указаны не будут.

В Яндекс.Вебмастере сообщения о нарушениях отображаются на вкладке «Диагностика»:

При наложении ручных санкций сайт либо его отдельные страницы могут быть просто пессимизированы в выдаче либо деиндексированы. Больше распространен первый сценарий. Пессимизация обычно предполагает просадку страниц на 10-20 позиций, что фактически полностью обнуляет их трафик. Вылет же из индекса грозит по большей части тем, кто использует практики черного SEO.

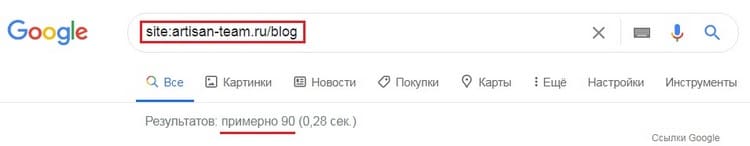

Проверить сайт или конкретный URL на пессимизацию/деиндексацию в конкретной поисковой системе проще всего через соответствующий запрос с оператором site:

Если сайт или страница пессимизированы, но остаются в индексе, они будут отображены в результатах поиска.

Чтобы восстановить позиции, просевшие в результате ручных санкций, необходимо устранить нарушения и запросить проверку в вебмастерке. Действия «для видимости» или половинчатые работы по исправлению – заведомо бесперспективный вариант. Этим можно только сильно затянуть решение проблемы, т. к. асессоры решат, что их время расходуют впустую, и они не будут спешить рассматривать повторные заявки.

К проседанию трафика в том числе иногда приводят происки конкурентов. Они могут:

Работа поисковых систем непрерывно совершенствуется. Это могут быть как локальные обновления алгоритмов, так и глобальные апдейты ядра поиска, которые сильно «штормят» выдачу и становятся причиной резких обвалов трафика по всему сайту.

Фатальные последствия медицинского апдейта в Google

Чтобы держать руку на пульсе главных технологических новостей, быть в курсе грядущих изменений и при необходимости успевать предпринимать нужные меры по оптимизации сайта, имеет смысл отслеживать официальные источники Google. Удобнее всего это делать через подписку на Google Search News на YouTube или Twitter.

Отдельно отметим, что даже глобальные обновления ядра Google, не всегда ощутимы в рунете (и другом неанглоязычном интернете). Здесь раскатка новых алгоритмов может происходить позже или не на полную силу и с менее драматическими последствиями. По субъективным наблюдениям, Google производит апдейты чаще, чем Яндекс. Особенно это касается локальных обновлений, влияние которых, впрочем, не всегда заметно в русскоязычном поиске. Тем не менее отслеживать новости в блоге Яндекса для вебмастеров – тоже нужно.

Просадки трафика в результате обновлений также называют алгоритмическими штрафами. Как и ручные санкции, они могут распространяться на весь сайт (этот сценарий более вероятен) или на отдельные страницы. В отличие от ручных штрафов, уведомления в этом случае не присылают, и о пессимизации приходится догадываться по косвенным признакам.

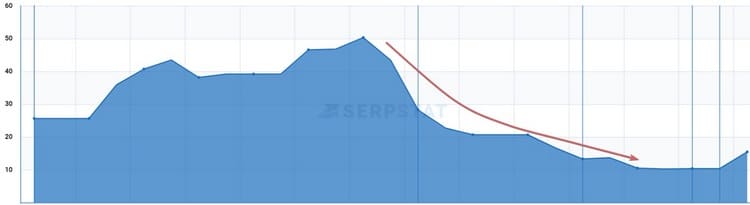

Один из способов подтвердить алгоритмический штраф – проверка динамики позиций. Обычно в этом случае они сначала дают незначительный рост, а затем резко проваливаются на несколько десятков пунктов.

Чтобы окончательно убедиться в этом предположении, берем фрагмент текста с любой просевшей страницы, и смотрим, как его обрабатывают поисковики. Если страница свалилась на 20-30 позицию, и перед ней ранжируются сайты, в которых даже отсутствуют ключевые слова из заданного фрагмента, почти нет никаких сомнений — это последствия алгоритмических санкций.

Поисковые системы могут пессимизировать сайт по самым разным причинам. Под раздачу попадают из-за:

При желании этот список можно продолжить, но в дополнение к вышесказанному мы сделаем отдельный акцент на группе ссылочных факторов. Именно за манипуляции с обратными и в меньшей степени с внутренними ссылками наиболее часто прилетают алгоритмические штрафы как в Google, так и в Яндексе.

При подозрении на алгоритмические санкции первым делом внимательно анализируют внешний и внутренний ссылочный профиль.

Резкий прирост спамных ссылок. Недобросовестные конкуренты могли проставить на вас нежелательные бэклинки, чтобы таким образом пессимизировать сайт и обойти его в выдаче. Чаще для этих целей используют специальные сервисы, поэтому прирост подозрительных ссылок при таком сценарии — резкий и массовый. В Google такие бэклинки отклоняют в Search Console через инструмент Disavow Links Tool. В Яндексе – пишут в поддержку.

Агрессивное наращивание ссылок. Возможно, постарались не конкуренты, а вы сами. В этом случае нужно сбавить обороты и отклонить большую часть недавно проставленных обратных ссылок.

Нерелевантные площадки. Ссылки с ресурсов, тематика которых не соответствует тематике сайта-реципиента, являются плохим сигналом для поисковых систем. Когда таких ссылок много, возможна пессимизация за т. н. социтирование.

Спам анкором. Для тех, кто не в теме: речь идет о ссылках, которые имеют кликабельный текст с вхождением запроса, причем, как правило, коммерческим. Такие бэклинки расцениваются Google и Яндексом как потенциально спамные, при этом, если мы говорим о настоящих анкорных ссылках, они способны хорошо качать SEO. Многие оптимизаторы пытаются воспользоваться этим эффектом, и выдать искусственные анкор-линки за естественные. В небольших количествах это работает. Но если переусердствовать – прилетит штраф.

Исходящие ссылки превалируют над входящими. И Google, и Яндекс борются с сайтами, которые агрессивно монетизируются благодаря продаже ссылок.

Много битых ссылок. В большей степени это актуально для Google, который более требователен к факторам, влияющим на качество взаимодействия пользователя с сайтом.

Отдельно отметим, что здесь прослеживается закономерность: чем моложе сайт, тем выше вероятность алгоритмических санкций за манипуляции с обратными ссылками.

Во многих тематических нишах изменения в объеме трафика подчиняются сезонной логике. Это означает, что посещаемость на сайте может упасть ввиду естественных причин – поскольку тема временно не актуальна. Несмотря на то что это, по сути, внешний фактор, мы все равно решили включить его список рассматриваемых причин, поскольку поправки на сезонные проседания трафика можно частично корректировать с помощью внутренней оптимизации.

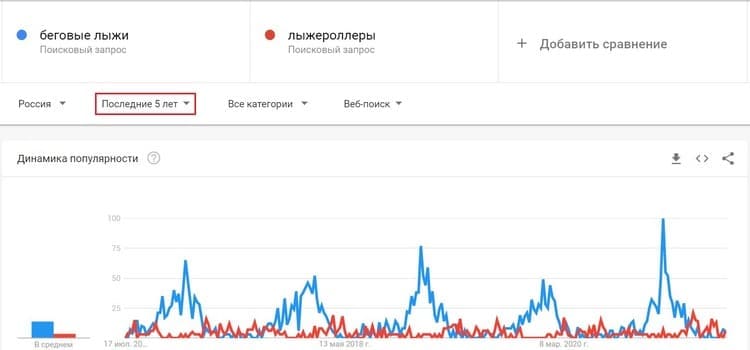

Подтвердить сезонные проседания посещаемости просто. Достаточно посмотреть динамику популярности темы или конкретного запроса в Google Trends (за несколько лет). Это же можно сделать через сервис Яндекс.Вордстат.

Чтобы окончательно убедиться, что просадка связана с сезонностью, сравниваем трафиковость сайта или отдельных страниц с предыдущими годами. Если динамика проседаний повторяется в одни и те же периоды, нет никаких сомнений, что это сезонная зависимость.

Почти для каждой ниши актуальны такие колебания. В одних тематиках они очевидны, например, если это зимние/летние виды спорта, сад и огород, праздники и пр., но по некоторым запросам сезонность интереса не столь логичная. Особенно часто такое прослеживается в сфере товаров. Например, вряд ли сразу можно предположить, что запросы, связанные с селфи-палками, подчиняются сезонной зависимости.

Вебмастерам важно знать сезонные кластеры своих сайтов и подготавливать контент таким образом, чтобы на период простоя одних запросов трафик генерировали другие. Поскольку мы заговорили o сервисе Google Trends, вкратце напомним, как можно использовать другие его возможности, чтобы получать еще больше трафика:

Больше о сценариях использования Google Trends для продвижения сайта – читайте в отдельном материале.